Sorry, we've misplaced that URL or it's pointing to something that doesn't exist.

Sorry, we've misplaced that URL or it's pointing to something that doesn't exist.

(。・∀・)ノ゙Hi. My name is Linze. We can make a friend, I suppose. I hope you can enjoy my blogs.

My research interests are …

In this role I was doing the job with crawling the commodity information of foreign e-commerce websites, such as size or color, etc.

YYYY: Name et al. Article title. Journal name. Link/DOI

To be continued…

YYYY: Description of award, certificate, supporting info etc.

To be continued…

Email: zee_lin@foxmail.com

QQ/Wechat: 493103671

本篇博客不阐述原理,只是记录一些知识点以及常用的C++函数代码。

这两个符号都是C++成员运算符1,主要用于确定类对象和成员之间的关系,用于引用类、结构和共用体的成员。

箭头运算符->与一个指针对象的指针一起使用。如果是指针访问数据成员或成员函数,用->;

点运算符.与实际的对象一起使用。如果是某个数据类型的对象,访问自己的数据成员和成员函数用.;

举个例子:

1

+2

+3

+4

+

string s1 = "a string",*p = &s1;

+int n = s1.size(); //运行string对象s1的size()成员

+n = (*p).size(); //运行p所指对象的size成员

+n = p->size(;) //等价于(*p).size

+

左移乘,右移除

bitset.count()函数用于统计二进制数中1的数量。

__builtin_popcount()函数也可以统计二进制中1的数量。

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+

#include<bits/stdc++.h>

+using namespace std;

+int main() {

+ unsigned short short1 = 4;

+ bitset<16> bitset1(short1); // the bitset representation of 4

+ cout << bitset1 << endl; // 0b00000000'00000100

+

+ unsigned short short2 = short1 << 1; // 4 left-shifted by 1 = 8

+ bitset<16> bitset2(short2);

+ cout << bitset2 << endl; // 0b00000000'00001000

+

+ unsigned short short3 = short1 >> 2; // 4 right-shifted by 2 = 1

+ bitset<16> bitset3(short3);

+ cout << bitset3 << endl; // 0b00000000'00000001

+

+ int int1 = 5;

+ bitset<4> bitset4(int1); // 0b1001

+ cout << bitset4.count() << endl; // number of set bits in bitset4 = 2

+ cout << __builtin_popcount(5) << endl; // same as above

+}

+

前序(preorder): 根结点 -> 遍历左子树 -> 遍历右子树 (首先访问根结点)

中序(inorder): 遍历左子树 -> 根结点 -> 遍历右子树

后序(postorder): 遍历左子树 -> 遍历右子树 -> 根结点 (最后访问根结点)

简介:n 个人围成一个圈,每次数 k 个数,被数到的那个人出局。

数学解法:

1

+2

+3

+4

+5

+6

+7

+

int findTheWinner(int n, int k) {

+ int p = 0;

+ for (int i = 2; i <= n; i++) {

+ p = (p + k) % i;

+ }

+ return p + 1;

+}

+

队列:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+

int findTheWinner(int n, int k) {

+ queue<int> q;

+ for(int i = 0; i < n; i++) q.push(i + 1);

+ while(q.size() != 1){

+ for(int i = 0; i < k - 1; i++){

+ q.push(q.front());

+ q.pop();

+ }

+ q.pop();

+ }

+ return q.front();

+}

+

STL: Standard Template Library

emplace可以代替insert. emplace_back可以代替push_back. emplace_front可以代替push_front.

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+

mylist.front()

+mylist.back()

+mylist.begin()

+mylist.end()

+mylist.empty()

+

+mylist.erase()

+mylist.remove()

+

+mylist.insert()

+

+mylist.pop_back()

+mylist.pop_front()

+mylist.push_back()

+mylist.push_front()

+

+mylist.reverse()

+mylist.sort()

+

+mylist.unique()

+

emplace可以代替insert. emplace_back可以代替push_back. emplace_front可以代替push_front.

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+

myvector.front()

+myvector.back()

+myvector.size()

+

+myvector.begin()

+myvector.end()

+

+for(vector<int>::iterator it = myvector.begin();it!=myvector.end();it++){

+ cout<<*it<<endl;

+}

+

+myvector.clear()

+

+myvector.pop_back()

+myvector.push_back()

+

+myvector.empty()

+myvector.insert()

+

emplace可以代替push

1

+2

+3

+4

+5

+6

+

myqueue.push()

+myqueue.pop()

+myqueue.empty()

+myqueue.size()

+myqueue.front()

+myqueue.back()

+

emplace可以代替push

1

+2

+3

+4

+5

+

mystack.empty()

+mystack.pop()

+mystack.push()

+mystack.size()

+mystack.top() //栈顶,即出入口

+

emplace可以代替insert

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+

// 不需要对key进行排列或数据量不小于10000的时候,用unordered_map.

+

+unordered_map<char,int> mymap;

+mymap['a'] = 100;

+mymap['b'] = 200;

+

+for(map<char,int>::iterator it = mymap.begin();it != mymap.end(); it++){

+ cout<<it->first<<" => " <<it->second<<endl;

+}

+

+mymap.size()

+

+mymap.clear()

+

+mymap.count(k) //return 1 if found or 0 otherwise

+

+mymap.erase(key)

+mymap.erase(iterator first,iterator last)

+

+it = mymap.find('b')

+mymap.insert()

+

emplace可以代替insert

1

+2

+3

+

unordered_set<int> myset;

+

+unordered_set<pair<int, string>> myset;

+

优先队列与堆类似。默认大顶堆。

和队列基本操作相同:

top()访问队头元素empty()队列是否为空size()返回队列内元素个数push()插入元素到队尾 (并排序)emplace()原地构造一个元素并插入队列pop()弹出队头元素

1

+2

+3

+4

+5

+

//大顶堆,即降序队列

+priority_queue<int> big_heap;

+priority_queue<int, vector<int>, less<int> > big_heap2;

+//小顶堆,即升序队列

+priority_queue<int, vector<int>, greater<int> > small_heap;

+

pair的比较,先比较第一个元素,第一个相等比较第二个

1

+2

+3

+4

+

//大顶堆,即降序队列

+priority_queue<pair<int, int> > big_pair_heap;

+//小顶堆,即升序队列

+priority_queue<pair<int, int>, vector<pair<int, int>>, greater<>> small_pair_heap;

+

lower_bound()和upper_bound()是利用二分查找的方法在一个排好序的容器中进行查找,比如set,vector,map容器。具体用法如下所示:

lower_bound(value): 第一个大于等于(可以是字典序,也可以是值)value的下标或者指针upper_bound(value): 第一个大于(可以是字典序,也可以是值)value的下标或者指针map:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+

map<char,int> mymap;

+mymap['a']=20;

+mymap['b']=40;

+mymap['c']=60;

+mymap['d']=80;

+mymap['f']=100;

+map<char,int>::iterator itlow=mymap.lower_bound ('b'); // itlow points to b

+map<char,int>::iterator temp=mymap.upper_bound ('d'); // temp points to f (not d!)

+map<char,int>::iterator itup=mymap.upper_bound ('e'); // there's no e, so itup points to f

+mymap.erase(itlow,itup); // erases [itlow,itup)

+

set:

1

+2

+3

+4

+5

+6

+7

+

set<int> myset;

+for (int i=1; i<10; i++) myset.insert(i * 10); // 10 20 30 40 50 60 70 80 90

+set<int>::iterator temp1=myset.lower_bound (25); // 30 >= 25,so temp1 points to 30

+set<int>::iterator temp2=myset.lower_bound (60); // 70 > 60,so temp2 points to 70

+set<int>::iterator itlow=myset.lower_bound (30); // itlow points to 30

+set<int>::iterator itup=myset.upper_bound (65); // itup points to 70

+myset.erase(itlow,itup); // erases [itlow,itup)

+

int index = mystring.find(s, pos);

其中 s 可以是字符也可以是字符串,pos 是寻找字符或字符串的起始位置。

1

+2

+3

+

string str = "abcdefgabc";

+int index = str.find("abc"); // index = 0

+int index = str.find("abc", 3); // index = 7

+

string str = mystring.substr(pos, len);2

Example

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+

// string::substr

+#include <iostream>

+#include <string>

+

+int main ()

+{

+ std::string str="We think in generalities, but we live in details."; // (quoting Alfred N. Whitehead)

+

+ std::string str2 = str.substr (3,5); // "think"

+

+ std::size_t pos = str.find("live"); // position of "live" in str

+

+ std::string str3 = str.substr (pos); // get from "live" to the end

+

+ std::cout << str2 << ' ' << str3 << '\n';

+

+ return 0;

+}

+

Output:

think live in details.

string str = to_string(a); 3

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+27

+28

+

include<bits/stdc++.h>

+

+struct person{ // structure

+ double a;

+ double b;

+}temp[100];

+

+getline(cin,s);

+

+int a; // int to string

+string str = to_string(a);

+

+string b; // string to int

+int int1 = atoi(b.c_str()); //遇到字母会自动停下,如果没有数字,则定义为0 。b为string类型的情况下还需要使用c_str()函数

+int int2 = stoi(b); //遇到字母会自动停下,如果没有数字,运行会出错

+

+string str; // length(string)

+int res = str.length();

+

+char *test; // length(char)

+int res = strlen(test);

+

+int num = 3;

+temp = string(num, 'a'); // "aaa"

+

+int i = 1, j = 4;

+int res = (i + j)/2; // 向下取整,res = 2;

+cout<<res<<endl;

+

动态分配与释放内存。与vector相比,使用malloc的效率更高。

分配一维与二维数组代码如下所示:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+

#include<bits/stdc++.h>

+using namespace std;

+

+int main(){

+ // 1-dimensional

+ int len = 10;

+ int *p;

+ p = (int *)malloc(len * sizeof(int));

+ free(p);

+ // 2-dimensional

+ int **a;

+ int row = 3; int col = 3;

+ a = (int **)malloc(row * sizeof(int*));

+ for(int i = 0; i < row; i++)

+ {

+ a[i] = (int *)malloc(col * sizeof(int));

+ }

+

+ for(int i = 0; i < row; i++)

+ {

+ free(a[i]);

+ }

+ free(a);

+}

+

1

+2

+3

+4

+5

+6

+

bool is_prime(int s){

+ if(s <= 3) return s > 1;

+ int sqt = sqrt(s);

+ for(int i = 2; i <= sqt; i++) if(s % i == 0) return false;

+ return true;

+}

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+

bool cmp(string a, string b){

+ if(a.length() != b.length()) return a.length() < b.length(); // 按长度升序:a的长度小于b的长度,所以从左到右长度变大。

+ return a > b; // 按字典序降序:a的字典序大于b的字典序,所以从左到右字典序降低。

+}

+

+int main(){

+ sort(temp1, temp1 + 4, cmp); // temp1为数组

+ sort(temp2.begin(), temp2.end(), cmp); // temp2为向量

+}

+

与sort()函数类似,可对数组、向量的任意区间求最大或最小值。

1

+2

+3

+4

+5

+6

+7

+8

+

#include<bits/stdc++.h>

+using namespace std;

+int main(){

+ int temp_myv[10] = {1, 2, 3, 4, 5, 6, 7, 8, 9, 10};

+ vector<int> myv(temp_myv, temp_myv + 10);

+ cout<<*min_element(temp_myv, temp_myv + 10)<<endl;

+ cout<<*max_element(myv.begin(), myv.end())<<endl;

+}

+

1

+2

+3

+4

+

int a[5] = {1, 2, 3, 4, 5};

+vector<int> v(a);

+int sum = accumulate(a, a + 5, 0);

+int sum2 = accumulate(v.begin(), v.end(), 0);

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+

cout<<fixed<<setprecision(1)<<a<<endl; // accurate to 1 decimal place

+

+cout<<setw(3)<<setfill('0')<<a<<endl; // filled with '0'

+printf("%03d",a); // if a=1; 输出001

+

+

+cout<<hex<<12<<endl; // 十六进制输出

+cout<<oct<<12<<endl; // 八进制输出

+

+cout<<left<<setw(5)<<10<<endl; // 左对齐

+cout<<right<<setw(5)<<10<<endl; // 右对齐

+

+string a;

+int b,c;

+scanf("%s : %d :%d", &a[0], &b, &c); //可以隔着冒号取值,记得引用符号&

+printf("%s\n",a);

+

用于判断字符串s中的任意子串是否回文。

动态规划法:

judge[start][end]表示字符串s中[start, end]的子串是否为回文串。

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+

int n = s.length();

+vector<vector<bool> > judge(n, vector<bool>(n, true));

+// 从后往前去遍历

+for (int i = n - 1; i >= 0; --i)

+{

+ for (int j = i + 1; j < n; ++j)

+ {

+ // 判断i和j是否相等,相等则扩展

+ judge[i][j] = (s[i] == s[j]) && judge[i + 1][j - 1];

+ }

+}

+

双指针遍历法:

描述同动态规划法,适用于单次简单判断。若要判断字符串s的每个子串是否为回文串,复杂度则为O(n^3)。

1

+2

+3

+4

+5

+6

+

bool judge(string s, int start, int end){ // 双指针遍历

+ for(int i = start; i <= (start + end) / 2; i++){

+ if(s[i] != s[end + start - i]) return false;

+ }

+ return true;

+}

+

详细的二分查找分析见此。

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+

int nums[5] = {10, 20, 30, 40, 50};

+int flag = -1, target = 16;

+int i = 0, j = n - 1; // 前闭后闭

+while(i <= j){ // 因此i > j(即i == j + 1)时退出循环

+ int mid = i + (j - i)/2;

+ if(target == nums[mid]){

+ flag = mid;

+ break;

+ }

+ else if(target > nums[mid]) i = mid + 1; // mid已经遍历,所以新的区间为[i, mid - 1]或[mid + 1, j]

+ else j = mid - 1;

+}

+

排列(permutation):

\[A_{n}^{m} = \frac{n!}{(n - m)!} = (n - m + 1) * \cdots * (n - 1) * n\]1

+2

+3

+4

+5

+6

+7

+

int A(int n, int m) {

+ int res = 1;

+ for(int i = n - m + 1; i <= n; i++){

+ res *= i;

+ }

+ return res;

+}

+

组合(combination):

\[C_{n}^{m} = \frac{ A_{n}^{m} }{m!} = \frac{n!}{(n - m)!m!} = C_{n}^{n-m}\]1

+2

+3

+4

+5

+6

+

int C(int n, int m) {

+ m = min(m, n - m);

+ int numerator = A(n, m); //分子

+ int denominator = A(m, m); //分母

+ return numerator / denominator;

+}

+

大小写判断:

1

+2

+

for (int i = 0; i < str.size(); i++) if(islower(str[i])) return false; // bool islower(int c);

+for (int i = 0; i < str.size(); i++) if(isupper(str[i])) return false; // bool isupper(int c);

+

大小写转换:

1

+2

+

for (int i = 0; i < str.size(); i++) str[i] = tolower(str[i]); // int tolower(int c);

+for (int i = 0; i < str.size(); i++) str[i] = toupper(str[i]); // int toupper(int c);

+

max()、min()函数中只有两个参数,意味着只能在两个数中取最大或者最小值。

当需要对三个及以上的数字取最大或最小值时,可用以下方法。

1

+2

+3

+4

+5

+6

+7

+8

+9

+

int x = 6, y = 2, z = 10;

+int m1 = max({x,y,z});

+int m2 = max<int>({x,y,z});

+int m3 = max({(int)x,y,z});

+

+double a = 9.2, b = 2.4, c = 5.5555;

+double n1 = min({a,b,c});

+double n2 = min<double>({a,b,c});

+double n3 = min({(double)a,b,c});

+

或者:

1

+2

+3

+

int maxn(int x, int y, int z){

+ return max(max(x, y), z);

+}

+

伪随机数:

rand() / double(RAND_MAX) 产生随机数的范围是 [0, 1]

rand() / double(RAND_MAX) * 2 * r 产生随机数范围为 [0, 2r]

rand() / double(RAND_MAX) * 2 * r - r + x 产生随机数范围为 [x - r, x + r]

真随机数:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+

#include <random>

+#include <iostream>

+

+int main()

+{

+ std::random_device rd; // random_device 是一个“真随机数”发生器,它的缺点就是耗能太大,所以尽量别奢侈地一直用它

+ std::mt19937 gen(rd()); // 用 random_device产生一个真随机数,用作“伪随机数发生器”的种子,此后就雪藏之

+ std::uniform_int_distribution<> dis(1, 6); // 一个正态“分布器”,高斯分布器是 std::normal_distribution

+

+ for (int n=0; n<10; ++n)

+ // 用 dis 变换 gen 所生成的随机 unsigned int 到 [1, 6] 中的 int

+ std::cout << dis(gen) << ' ';

+ std::cout << '\n';

+}

+

1

+2

+

//初始化一个size为0的vector

+vector<int> abc;

+

1

+2

+3

+4

+

//初始化size,但每个元素值为默认值

+vector<int> abc(10); //初始化了10个默认值为0的元素

+//初始化size,并且设置初始值

+vector<int> cde(10, 1); //初始化了10个值为1的元素

+

1

+2

+3

+

int a[5] = {1, 2, 3, 4, 5};

+//通过数组a的地址初始化,注意地址是从0到5(左闭右开区间)

+vector<int> b(a, a + 5);

+

1

+2

+3

+

vector<int> a(5, 1);

+//通过a初始化

+vector<int> b(a);

+

1

+2

+3

+4

+5

+

//insert初始化方式将同类型的迭代器对应的始末区间(左闭右开区间)内的值插入到vector中

+vector<int> a(6, 6);

+vecot<int> b;

+//将a[0]~a[2]插入到b中,b.size()由0变为3

+b.insert(b.begin(), a.begin(), a.begin() + 3);

+

insert也可通过数组地址区间实现插入

1

+2

+3

+4

+

int a[6] = {6, 6, 6, 6, 6, 6};

+vector<int> b;

+//将a的所有元素插入到b中

+b.insert(b.begin(), a, a + 6);

+

此外,insert还可以插入m个值为n的元素

1

+2

+

//在b开始位置处插入3个6

+b.insert(b.begin(), 3, 6);

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+

vector<int> a(5, 1);

+int a1[5] = {2, 2, 2, 2, 2};

+vector<int> b(10);

+

+/*将a中元素全部拷贝到b开始的位置中,注意拷贝的区间为a.begin() ~ a.end()的左闭右开的区间*/

+copy(a.begin(), a.end(), b.begin());

+

+//拷贝区间也可以是数组地址构成的区间

+copy(a1, a1 + 5, b.begin() + 5);

+

vector<vector<int> > myv(row, vector<int>(column,0));

1

+2

+3

+4

+5

+

vector<vector<int> > myv(5, vector<int>(10,0)); // 两个维度都是向量

+cout<<myv.size()<<endl; // 正确,因为向量有size()函数

+

+vector<int> temp(2);

+myv.push_back(temp); // 正确,可以将向量插入到向量中

+

或者:

1

+2

+3

+

vector<vector<int> > myv(5); // 两个维度都是向量,只是第二个维度的向量长度为0

+cout<<myv.size()<<endl; // 5

+cout<<myv[0].size()<<endl; // 0

+

vector<vector<int>> v(5) 大于号之间没有空格的初始化方式在C++11之后也是正确的,即C++11以后允许两个大于号之间没有空格。C++11是一种标准。

1

+2

+3

+4

+5

+

vector<int> myv[n]; // 此时第一维是数组,第二维才是向量。

+// cout<<myv.size()<<endl; // 错误,因为数组没有size()函数

+

+vector<int> temp(2);

+myv.push_back(temp); // 错误,无法将向量插入到数组中

+

Elasticsearch是基于 Lucene 架构实现的分布式、海量数据的存储分析引擎,其中 Lucene 最主要的倒排索引结构,赋予了ES全文检索、模糊匹配、联合索引查询等等快速检索文档数据的能力,使得ES在这些查询的应用场景下优于数据库。适合用于搜索,不适合复杂的关系查询

倒排索引:被用来存储在全文搜索下某个单词在一个文档或者一组文档中的存储位置的映射。

本质上都是写操作!磁盘上的每个段都有一个相应的 .del 文件。

.del 文件中被标记为删除的文档将不会被写入新段。大概分为三个步骤:write -> refresh -> flush

1、write:文档数据到内存缓存,并存到 translog

2、refresh:内存缓存中的文档数据,到文件缓存中的 segment 。此时可以被搜到。

3、flush: 缓存中的 segment 文档数据写入到磁盘

当数据添加到索引后并不能马上被查询到,等到索引刷新后才会被查询到。refresh_interval 参数设置为正数之后,需要等一段时间后才可以在es索引中搜索到,因为已经从内存缓存刷新到文件缓存中了。详见数据写入与查询存在时间差问题

Term Index: 倒排的树状结构,存在内存里,是Term dictionary的索引。

基本概念:

分片与副本的区别在于:

尽可能使用过滤器上下文(Filter)替代查询上下文(Query)

Elasticsearch 针对 Filter 查询只需要回答「是」或者「否」,不需要像 Query 查询一样计算相关性分数,同时Filter结果可以缓存。

Scroll Query + Bulk

Ingest pipeline 可以在数据存入ES之前对数据进行转换,例如转小写,增加字段等。

性能优化:

背景:每五分钟就有6.5M条数据,直接reindex需要1000s(15分钟)

text类型: text类型是指可分词的文本,适用于长文本或短语查询。当文本被索引时,会被分成一些个别单词或词组,并且会去除停用词(如“a”、“the”、“and”等)和标点符号。这些单词或词组将被标准化并存储在倒排索引中,使得搜索时可以更快地匹配文档。适合全文搜索。

keyword类型: keyword类型是指未经过分词处理的文本,适用于精确匹配和排序。当文本被索引时,会被作为一个整体进行索引。它们通常用于搜索和排序非文本字段,例如数字或日期。适合过滤、排序、聚合。

ElasticSearch 默认为text类型,但是text类型总会有keyword的类型的字段,等价于 .keyword

垂直扩容(纵向扩容):替换旧的设备

水平扩容(横向扩容):直接新增设备到集群中,会触发relocation

针对写入和更新时可能出现的并发问题,ES是通过文档版本号来解决的。当用户对文档进行操作时,并不需要对文档加锁和解锁操作,只需要带着版本号。当版本号冲突的时候,ES会提示冲突并抛出异常,并进行重试

查询时,会把所有的segment查询结果汇总归并为最终的分片查询结果返回。

为了实现高索引速度,故使用了segment 分段架构存储。

一批写入数据保存在一个段中,其中每个段是磁盘中的单个文件。

由于两次写入之间的文件操作非常繁重,因此将一个段设为不可变的,以便所有后续写入都转到New段。

可以是内存里的段,也可以是在磁盘里的段进行段合并

.del 文件里标记为删除)。在合并过程中ES会进行数据的排序和去重,并重新生成倒排索引由于自动刷新流程每秒会创建一个新的段(由动态配置参数:refresh_interval 决定),这样会导致短时间内的段数量暴增。而段数目太多会带来较大的麻烦,导致:

后台进程定期检查,可能进行 merge 操作

单击图片即可得到HSV或BGR的值,代码如下:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+

import cv2

+

+def getposHsv(event, x, y, flags, param):

+ if event == cv2.EVENT_LBUTTONDOWN:

+ print("HSV is", HSV[y, x])

+

+def getposBgr(event, x, y, flags, param):

+ if event == cv2.EVENT_LBUTTONDOWN:

+ print("BGR is", image[y, x])

+

+image = cv2.imread('frame_B.jpg')

+HSV = cv2.cvtColor(image, cv2.COLOR_BGR2HSV)

+cv2.imshow("imageHSV", HSV)

+cv2.imshow('image', image)

+cv2.setMouseCallback("imageHSV", getposHsv)

+cv2.setMouseCallback("image", getposBgr)

+cv2.waitKey(0)

+

1

+2

+3

+

var s string = "string"

+var s = "string"

+s := "string"

+

1

+2

+3

+4

+

slice1 := make([][]bool, m)

+for i := range slice1 {

+ slice1[i] = make([]bool, n)

+}

+

只有后缀自增或自减,并且必须单独一行(除了在range语句中)。

条件判断语句中的初始变量可以在布尔表达式里,并且不能使用0/1作为判断条件。

1

+2

+3

+

if cond := true; cond {

+ fmt.Println()

+}

+

生成 [0, 99] 的随机数

1

+2

+3

+

rand.Seed(time.Now().UnixNano())

+r := rand.Intn(100)

+fmt.Println(r)

+

Go 语言中的栈和队列都是基于切片实现的。

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+

stack := make([]int, 0) //创建切片

+stack = append(stack, 10) //push压入栈

+value := stack[len(stack)-1] // 取栈顶的值

+stack = stack[:len(stack)-1] //pop弹出

+len(stack) == 0 //检查栈空

+

+queue := make([]int, 0) //创建切片

+queue = append(queue, 10) //enqueue入队

+v := queue[0] // 取队首的值

+queue = queue[1:] //dequeue出队

+len(queue) == 0 //检查队列为空

+

1

+2

+3

+4

+

slice1 := []string{"Moe", "Larry", "Curly"}

+slice2 := []string{"php", "golang", "java"}

+slice3 = append(slice1, slice2...)

+fmt.Println(slice3)//[Moe Larry Curly php golang java]

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+

// string to int, "99" -> 99

+int, err := strconv.Atoi(str)

+

+// asscii to string, 97 -> "a"

+str := string(asscii) // asscii to string

+

+// int to string, 10 -> "10"

+str := fmt.Sprintf("%d", int)

+str := strconv.Itoa(int)

+str := strconv.FormatInt(int, 10)

+

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+

// 数组

+var pow = []int{1, 2, 4, 8, 16, 32, 64, 128}

+for i, v := range pow {

+ fmt.Printf("2**%d = %d\n", i, v)

+}

+// Map

+for key, value := range oldMap {

+ newMap[key] = value

+}

+for key := range oldMap {

+ fmt.Println(oldMap[key])

+}

+for _, value := range oldMap {

+ fmt.Println(value)

+}

+

+// 字符串。第一个参数是字符的索引,第二个是字符(Unicode的值)本身。

+for i, c := range "go" {

+ fmt.Println(i, c, string(c)) //0 103 g \n 1 111 o

+}

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+

fmt.Printf("int min - max: %d - %d\n", math.MinInt, math.MaxInt) // int

+fmt.Printf("int8 min - max: %d - %d\n", math.MinInt8, math.MaxInt8) // int8

+fmt.Printf("int16 min - max: %d - %d\n", math.MinInt16, math.MaxInt16) // int16

+fmt.Printf("int32 min - max: %d - %d\n", math.MinInt32, math.MaxInt32) // int32

+fmt.Printf("int64 min - max: %d - %d\n", math.MinInt64, math.MaxInt64) // int64

+// unsigned

+fmt.Printf("uint min - max: %d - %d\n", uint(0), uint(math.MaxUint)) // uint

+fmt.Printf("uint8 min - max: %d - %d\n", 0, math.MaxUint8) // uint8

+fmt.Printf("uint16 min - max: %d - %d\n", 0, math.MaxUint16) // uint16

+fmt.Printf("uint32 min - max: %d - %d\n", 0, math.MaxUint32) // uint32

+fmt.Printf("uint64 min - max: %d - %d\n", 0, uint64(math.MaxUint64)) // uint64

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+

// int

+array := []int{3, 1, 34, 25, 14, 5}

+sort.Ints(array) // 升序

+fmt.Println(array)

+sort.Sort(sort.Reverse(sort.IntSlice(array))) // 降序

+fmt.Println(array)

+// string

+array1 := []string{"ss", "sa", "avs", "vs"}

+sort.Strings(array1)

+fmt.Println(array1)

+sort.Sort(sort.Reverse(sort.StringSlice(array1)))

+fmt.Println(array1)

+

1

+2

+3

+4

+5

+6

+7

+8

+

array := []int{3, 17, 1, 34, 25, 14, 5}

+sort.Slice(array, func(i, j int) bool {

+ if abs(array[i]-9) != abs(array[j]-9) {

+ return abs(array[i]-9) < abs(array[j]-9)

+ }

+ return array[i] < array[j]

+})

+fmt.Printf("%+v", array)

+

1

+2

+3

+4

+

doubleLinkedList := list.New()

+doubleLinkedList.PushBack(3)

+var doubleLinkedListElement *list.Element

+doubleLinkedListElement = doubleLinkedList.Back()

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+

m := make(map[string]int) // 初始化

+

+m := map[string]int{ // 使用组合字面量初始化

+ "apple": 1,

+ "banana": 2,

+ "orange": 3,

+}

+

+v1 := m["apple"] // 获取键值对

+v2, ok := m["pear"] // 如果键不存在,ok 的值为 false,v2 的值为该类型的零值

+

+for k, v := range m { // 遍历Map,无序的

+ fmt.Printf("key=%s, value=%d\n", k, v)

+}

+delete(m, "banana") // 删除元素

+m := make(map[string]int) // 清空元素的方法就是重新make一个map

+

+// 基于 Map 实现 Set

+set := make(map[string]bool)

+set["Foo"] = true

+for k := range set {

+ fmt.Println(k)

+}

+delete(set, "Foo")

+size := len(set)

+exists := set["Foo"]

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+27

+28

+29

+30

+31

+32

+33

+34

+35

+36

+37

+38

+39

+40

+41

+42

+43

+

package main

+

+import (

+ "container/heap"

+ "fmt"

+ "sort"

+)

+

+type heap2 struct {

+ sort.IntSlice

+}

+

+func (h heap2) Less(i, j int) bool { // 最小堆:h.IntSlice[i] < h.IntSlice[j];最大堆:h.IntSlice[i] > h.IntSlice[j];

+ return h.IntSlice[i] > h.IntSlice[j]

+}

+

+func (h *heap2) Push(v interface{}) {

+ h.IntSlice = append(h.IntSlice, v.(int))

+}

+

+func (h *heap2) Pop() interface{} {

+ temp := h.IntSlice

+ v := temp[len(temp)-1]

+ h.IntSlice = temp[:len(temp)-1]

+ return v

+}

+

+func (h *heap2) push(v int) {

+ heap.Push(h, v)

+}

+

+func (h *heap2) pop() int {

+ return heap.Pop(h).(int)

+}

+

+func main() {

+ q := &heap2{[]int{3, 4, 1, 2, 4, 3}}

+ heap.Init(q)

+ q.pop()

+ fmt.Println(len(q.IntSlice))

+ fmt.Println(q)

+}

+

+

s[x: y] 表示 s 中第 x 位到第 y - 1 位元素截取。进程:是具有一定独立功能的程序,是系统资源分配和调度的最小单位。每个进程都有自己的独立内存空间,不同进程通过进程间通信来通信。由于进程比较重量,占据独立的内存,所以上下文进程间的切换开销(栈、寄存器、虚拟内存、文件句柄等)比较大,但相对比较稳定安全。

线程:是进程的一个实体,是内核态,而且是CPU调度和分派的基本单位,它是比进程更小的能独立运行的基本单位。线程间通信主要通过共享内存,上下文切换很快,资源开销较少,但相比进程不够稳定容易丢失数据。

协程:是一种用户态的轻量级线程,调度完全是由用户来控制的拥有自己的寄存器上下文和栈。调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保存的寄存器上下文和栈,直接操作栈则基本没有内核切换的开销,可以不加锁的访问全局变量,所以上下文的切换非常快。一个线程可以有多个协程,线程、进程都是同步机制,但协程是异步

在Windows上使用RubyInstaller安装比较方便,在Ruby官网下载最新版本的RubyInstaller WITH DEVKIT。注意32位和64位版本的区分。

安装:使用默认路径即可,避免出错;勾选添加到PATH,就不用手动添加环境变量了

安装完成如图:

这里需要勾选Run 'ridk install',在弹出来的安装界面中选择3,安装MSYS2 and MINGW development toolchain:

在RubyGems官网下载ZIP格式的安装包,下载后解压到任意路径。进入解压目录,在终端输入命令:ruby setup.rb 或者直接双击setup.rb文件即可。

打开cmd输入以下命令并等待安装完成即可。

1

+2

+3

+

gem install jekyll

+gem install jekyll-paginate

+gem install bundler

+

1

+2

+

jekyll -v

+bundle -v

+

输出版本信息则代表安装没问题。

安装完成,我们可以用jekyll命令创建一个博客模板,进入一个目录,打开命令行执行:

1

+2

+3

+

jekyll new testblog

+cd testblog

+bundle exec jekyll serve

+

大功告成!

问题描述:执行 bundle exec jekyll serve 时出现 cannot load such file -- webrick (LoadError) 错误,如下图所示

解决方法:终端输入bundle add webrick.See here.

This post is to show Markdown syntax rendering on Chirpy, you can also use it as an example of writing. Now, let’s start looking at text and typography.

I wandered lonely as a cloud

That floats on high o’er vales and hills,

When all at once I saw a crowd,

A host, of golden daffodils;

Beside the lake, beneath the trees,

Fluttering and dancing in the breeze.

Nested and mixed lists are an interesting beast1. It’s a corner case to make sure that

Only one thing is impossible for God: To find any sense in any copyright law on the planet.

An example showing the

tiptype prompt.

An example showing the

infotype prompt.

An example showing the

warningtype prompt.

An example showing the

dangertype prompt.

🎨 Finally got around to adding all my @procreateapp creations with time lapse videos https://t.co/1nNbkefC3L pic.twitter.com/gcNLJoJ0Gn

— Michael Rose (@mmistakes) November 6, 2015

This post tests Twitter Embeds.

YouTube video embedded below.

Here is the code:

1

+

<iframe width="640" height="360" src="https://www.youtube.com/embed/fBnAMUkNM2k" frameborder="0" allowfullscreen></iframe>

+

| Header1 | Header2 | Header3 |

|---|---|---|

| left | center | right |

| left | center | right |

| left | center | right |

| left | center | right |

Welcome to image alignment! The best way to demonstrate the ebb and flow of the various image positioning options is to nestle them snuggly among an ocean of words. Grab a paddle and let’s get started.

The image above happens to be centered.

The rest of this paragraph is filler for the sake of seeing the text wrap around the 150×150 image, which is left aligned.

The rest of this paragraph is filler for the sake of seeing the text wrap around the 150×150 image, which is left aligned.

As you can see there should be some space above, below, and to the right of the image. The text should not be creeping on the image. Creeping is just not right. Images need breathing room too. Let them speak like you words. Let them do their jobs without any hassle from the text. In about one more sentence here, we’ll see that the text moves from the right of the image down below the image in seamless transition. Again, letting the do it’s thing. Mission accomplished!

And now for a massively large image. It also has no alignment.

The image above, though 1200px wide, should not overflow the content area. It should remain contained with no visible disruption to the flow of content.

And now we’re going to shift things to the right align. Again, there should be plenty of room above, below, and to the left of the image. Just look at him there — Hey guy! Way to rock that right side. I don’t care what the left aligned image says, you look great. Don’t let anyone else tell you differently.

In just a bit here, you should see the text start to wrap below the right aligned image and settle in nicely. There should still be plenty of room and everything should be sitting pretty. Yeah — Just like that. It never felt so good to be right.

And just when you thought we were done, we’re going to do them all over again with captions!

Once the position is specified, the image caption should not be added.

Full screen width and center alignment

Full screen width and center alignment

shadow effect (visible in light mode)

shadow effect (visible in light mode)

Float to left

“A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space.”

“A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space.”

Float to right

“A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space.”

“A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space. A repetitive and meaningless text is used to fill the space.”

gantt

+ title Adding GANTT diagram functionality to mermaid

+ apple :a, 2017-07-20, 1w

+ banana :crit, b, 2017-07-23, 1d

+ cherry :active, c, after b a, 1d

+The mathematics powered by MathJax:

\[\sum_{n=1}^\infty 1/n^2 = \frac{\pi^2}{6}\]When $a \ne 0$, there are two solutions to $ax^2 + bx + c = 0$ and they are

\[x = {-b \pm \sqrt{b^2-4ac} \over 2a}\]Here is the /path/to/the/file.extend.

1

+

This is a common code snippet, without syntax highlight and line number.

+

Using ```{language} you will get a code block with syntax highlight:

1

+2

+3

+

```yaml

+key: value

+```

+

1

+2

+3

+

$ env |grep SHELL

+SHELL=/usr/local/bin/bash

+PYENV_SHELL=bash

+

1

+2

+3

+4

+

if [ $? -ne 0 ]; then

+ echo "The command was not successful.";

+ #do the needful / exit

+fi;

+

1

+2

+3

+

@import

+ "colors/light-typography",

+ "colors/dark-typography"

+

By default, all languages except plaintext, console, and terminal will display line numbers. When you want to hide the line number of a code block, add the class nolineno to it:

1

+2

+3

+4

+

```shell

+echo 'No more line numbers!'

+```

+{: .nolineno }

+

For more knowledge about Jekyll posts, visit the Jekyll Docs: Posts.

This post has been updated and show a modified date.

| 优先级 | 运算符 |

|---|---|

| 1 | ( ) [ ] . |

| 2 | ! ~ ++ – |

| 3 | * / % |

| 4 | + - |

| 5 | « » «< »> |

| 6 | < <= > >= instanceof |

| 7 | == != |

| 8 | & |

| 9 | ^ |

| 10 | | |

| 11 | && |

| 12 | || |

| 13 | ? : |

| 14 | = += -= *= /= %= &= |= ^= ~= «= »= »>= |

| 15 | , |

总结:括号级别最高,逗号级别最低,单目 > 算术 > 位移 > 关系 > 逻辑 > 三目 > 赋值。

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+

+Deque<Integer> stack = new ArrayDeque<>(); // stack

+

+Deque<String> queue = new ArrayDeque<>(); // queue

+

+PriorityQueue<Integer> queue = new PriorityQueue<>(); // priority queue

+

+// Set

+

+HashSet<String> unordered_set = new HashSet<>(); // 乱序,底层使用散列函数

+

+LinkedHashSet<String> set = new LinkedHashSet<>(); // 以插入顺序排序

+

+TreeSet<String> set = new TreeSet<>(); // 以字典序排序,底层使用红黑树

+

+// Map

+

+HashMap<String, Object> unordered_map = new HashMap<>(); // 乱序

+

+LinkedHashMap<Integer, Integer> map = new LinkedHashMap<>(); // 以插入顺序排序

+

+TreeMap<Integer, Integer> map = new TreeMap<>(); // 以字典序排序

+

+TreeMap<Integer, Integer> map = new TreeMap<Integer, Integer>(); // 手动加泛型,多一些约束少一些出错。在运行期没有任何区别, java的泛型只在编译期有效。

+

+

ArrayList:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+

public static void main(String[] args) {

+ ArrayList<String> sites = new ArrayList<String>();

+ sites.add("Google");

+ sites.add("Runoob");

+ sites.add("Taobao");

+ sites.add("Weibo");

+ System.out.println(sites.get(1)); // 访问第二个元素

+ sites.set(2, "Wiki"); // 第一个参数为索引位置,第二个为要修改的值

+ sites.remove(3); // 删除第四个元素

+ Collections.sort(sites); // 字母排序

+ System.out.println(sites.isEmpty()); // 空判断

+ System.out.println(sites);

+ String[] arr = new String[sites.size()]; // 创建一个新的 String 类型的数组

+ sites.toArray(arr); // 将ArrayList对象转换成数组

+}

+

LinkedList:

1

+

+

HashSet:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+

public static void main(String[] args) {

+ HashSet<Integer> set = new HashSet<Integer>();

+ set.add(1);

+ set.add(2);

+ set.add(3);

+ set.remove(2);

+ System.out.println(set.contains(4));

+ for(int item: set){

+ System.out.println(item);

+ }

+}

+

HashMap:

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+27

+28

+29

+30

+31

+32

+33

+34

+35

+

public static void main(String[] args) {

+ Map<String, Integer> numbers = new HashMap<>();

+ numbers.put("One", 1);

+ numbers.put("Two", 2);

+ numbers.put("Three", 3);

+ numbers.put("Four", 4);

+ System.out.println(numbers.getOrDefault("Five", 0));

+ numbers.remove("Two");

+ numbers.replace("One",111);

+ System.out.println(numbers.containsKey("Four"));

+ System.out.println(numbers.containsValue(111));

+

+ // Method A(Recommended!)

+ numbers.forEach((k,v) -> System.out.println("Item: " + k + " Count: " + v));

+ numbers.forEach((k,v) -> {

+ System.out.println("Item: " + k + " Count: " + v);

+ if("Four".equals(k)){

+ System.out.println("Hello Four");

+ }

+ });

+ // Method B(Recommended!)

+ for (Map.Entry<String, Integer> entry : numbers.entrySet()) {

+ System.out.println("key:" + entry.getKey() + ".value:" + entry.getValue());

+ }

+ // Method C(NOT Recommended!)

+ for (String string : numbers.keySet()) {

+ System.out.println("key:" + string + ".value:" + numbers.get(string));

+ }

+ // Method D(Recommended When Deleting)

+ Iterator<String> iterators = numbers.keySet().iterator();

+ while (iterators.hasNext()) {

+ String key = iterators.next();

+ System.out.println("key:" + key + ".value:" + numbers.get(key));

+ }

+}

+

ArrayDeque:

在堆栈中,元素从栈顶插入,从栈顶弹出

在队列中,元素从队尾插入,从队首弹出

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+27

+28

+29

+30

+31

+32

+

public static void main(String[] args) {

+ ArrayDeque<String> animals= new ArrayDeque<>();

+ /*

+ *****Stack*****

+ */

+ animals.push("Pig");

+ System.out.println("返回栈顶元素: " + animals.peek());

+ System.out.println("返回栈顶元素并弹出: " + animals.pop());

+

+ /*

+ *****Queue*****

+ */

+ animals.offer("Horse");

+ System.out.println("返回队首元素: " + animals.peek());

+ System.out.println("返回队首元素并弹出: " + animals.poll());

+

+ /*

+ *****Deque*****

+ */

+ animals.push("Bird"); // 队首

+ animals.offer("Dog"); // 队尾

+ System.out.println("返回队首元素: " + animals.peek());

+ System.out.println("返回队首元素并弹出: " + animals.poll());

+ System.out.println("返回队尾元素: " + animals.peekLast());

+ System.out.println("返回队尾元素并弹出: " + animals.pollLast());

+

+ /*

+ *****Common*****

+ */

+ System.out.println("判断是否包含Dog: " + (animals.contains("Dog") ? "是" : "否"));

+ System.out.println("转换成数组输出: " + Arrays.toString(animals.toArray()));

+}

+

赋值是创建常量,在编译期时就被确定了;new创建的对象不是常量,无法在编译期中确定。

1

+2

+3

+4

+5

+6

+7

+8

+

+String s0 = "aaa" + "bbb"; // 常量,同"aaabbb",放入常量池中。创建了1个对象

+String s1 = "aaa" + new String("bbb"); // 非常量,因为new出来的字符串无法在编译期中确定。创建了4个对象

+String s2 = new String("aaabbb"); // 同上。由于常量池中已经存在"aaabbb",因此只创建了1个对象

+System.out.println(s1.intern() == s0); // true,intern()函数会在常量池里找是否相同的字符串,有则返回常量池的引用

+System.out.println(s2.intern() == s0); // true,同上

+System.out.println(s0 == s1); // false,虽然内容一样,但是new出来的地址肯定不一样

+System.out.println(s1 == s2); // false,同上

+

SEE HERE

赋值是给变量绑定一个新对象,而不是改变对象。

举例:

1

+2

+3

+4

+5

+6

+7

+8

+9

+

public static void main(String[] args) {

+ String x = new String("沉默王二");

+ change(x);

+ System.out.println(x); // "沉默王二"

+}

+

+public static void change(String x) {

+ x = "沉默王三";

+}

+

直接改变对象内容。

举例:

1

+2

+3

+4

+5

+6

+7

+8

+9

+

public static void change(A a) {

+ a.name = "bbb";

+}

+public static void main(String[] args) {

+ A a = new A();

+ a.name = "aaa";

+ change(a);

+ System.out.println(a.name); // "bbb"

+}

+

一棵含有n个节点的红黑树的高度至多为2log(n+1).See Here.

同步容器主要包括2类:

Vector、Stack、HashTable

Collections类中提供的静态工厂方法创建的类

同步容器的所有操作并不都是线程安全的。HERE

所谓“线程安全”,并不包括多个操作之间的“原子性”支持。

100%的情况下不要用 StringBuffer

99% 的情况下不要用 Vector

那么那剩下的 1% 用 Vector 的情况在哪呢?

熟悉Swing的都知道: 现有的一些 model 的类里面用了 Vector,假如你去定制它们,有时不可避免要用到 Vector。

与StringBuffer相比,StringBuilder不是线程安全,所以单线程情况下效率更高。两者除线程安全方面之外无差别。

1

+2

+

StringBuilder sb = new StringBuilder();

+sb.append("a".repeat(100)); // repeat方法用于构造重复String

+

三大特点:封装继承多态。

语法糖:switch支持String、泛型、自动拆装箱、变长参数、枚举、内部类、条件编译、断言、数值下划线、for-each、try-with-resources、Lambda表达式

装箱:Integer i = Integer.valueOf(10), 拆箱:int n = i.intValue()

运行时数据区域包含线程私有的程序计数器、虚拟机栈、本地方法栈,线程共享的堆(包含字符串常量池)和非运行时数据区的元空间(包含类常量池和运行时常量池)、直接内存。

OutOfMemoryError 的内存区域。String#intern 的用法。JMM 旨在提供一个统一的可参考的规范,屏蔽平台内存访问差异性。这个规范为读写共享变量时如何与内存交互提供了规则和保证。并发编程中,程序会因为 CPU 多级缓存或指令重排序等出现问题,因此需要一些规范要保证并发编程的可靠性。

关键概念包括:

JMM 为处理共享变量定义了三个特征(多线程中的概念):

通过内存屏障来保证可见性的

happens-before原则定义如下:

As-if-serial的意思是所有的语句都可以为了优化而被重排序,但是必须保证它们重排序后的结果和程序代码本身的应有结果是一致的。为保证as-if-serial语义,Java异常处理机制也会为重排序做一些特殊处理。

在每个volatile读操作后插入LoadLoad屏障,在读操作后插入LoadStore屏障。

在每个volatile写操作的前面插入一个StoreStore屏障,后面插入一个SotreLoad屏障。

线程上下文类加载器:破坏了“双亲委派模型”,可以在执行线程中抛弃双亲委派加载链模式,使程序可以逆向使用类加载器,例如SPI (Service Provider Interface)。SPI接口中的代码经常需要加载具体的实现类。SPI接口是Java核心库的一部分,由 启动类加载器(Bootstrap Classloader) 来加载,而实现类由 系统类加载器(AppClassLoader) 来加载。

双亲委派机制概念:双亲委派机制是指当一个类加载器收到某个类加载请求时,该类加载器首先会把请求委派给父类加载器。每个类加载器都是如此,它会先委托父类加载器在自己的搜索范围内找不到对应的类时,该类加载器才会尝试自己去加载。

Tomcat中的类加载器:

Java的SPI:SPI 的本质是将接口实现类的全限定名配置在文件中,并由服务加载器读取配置文件,加载实现类。当服务的提供者提供了服务接口的一种实现之后,在jar包的META-INF/services/目录里同时创建一个以服务接口命名的文件。该文件里就是实现该服务接口的具体实现类。而当外部程序装配这个模块的时候,就能通过该jar包META-INF/services/里的配置文件找到具体的实现类名,并装载实例化,完成模块的注入。

1.6 -> 1.7 -> 1.8:

JVM触发GC时,首先会让所有的用户线程到达安全点SafePoint时阻塞,也就是STW,然后枚举根节点,即找到所有的GC Roots,通过可达性算法向下搜寻活跃对象,可达的对象就保留,不可达的对象就回收。

空间担保策略是 JVM 的一种机制,发生 Minor GC 之前,虚拟机会检查老年代最大可用的连续空间是否大于新生代所有对象的总空间。如果小于,则虚拟机会查看HandlePromotionFailure设置值是否允许担保失败。如果HandlePromotionFailure=true,那么会继续检查老年代最大可用连续空间是否大于历次晋升到老年代的对象的平均大小,如果大于,则尝试进行一次Minor GC,但这次Minor GC依然是有风险的;如果小于或者HandlePromotionFailure=false,则改为进行一次Full GC。

垃圾收集器发展历程:

CMS(Concurrent Mark Sweep)收集器: 基于标记-清除算法,在Minor GC时会暂停所有的应用线程,并以多线程的方式进行垃圾回收。在Full GC时不再暂停应用线程,而是使用若干个后台线程定期的对老年代空间进行扫描。

Garbage First(G1)收集器:

-XX:MaxGCPauseMillis-XX:SurvivorRatio=6, -XX:NewRatio=4-XX:InitialTenuringThreshol=7-XX:PretenureSizeThreshold=1000000//新生代可容纳的最大对象,大于则直接会分配到老年代,0代表没有限制。调优的一条经验总结:

将新对象预留在新生代,由于 Full GC 的成本远高于 Minor GC,因此尽可能将对象分配在新生代是明智的做法,实际项目中根据 GC 日志分析新生代空间大小分配是否合理,适当通过“-Xmn”命令调节新生代大小,最大限度降低新对象直接进入老年代的情况。

NIO vs IO:

IO多路复用(事件驱动):一个线程不断轮询多个socket的状态,只有当socket真正有读写状态时,借用当前线程或者使用线程池额外启动线程,调用实际的IO读写操作。

Java NIO:

一个 Java 程序的运行是 main 线程和多个其他线程同时运行。

底层都是通过对象头里 Mark Word 指向的对象监听器(Monitor)实现的,再底层是操作系统的互斥量(mutex)实现的

同一时刻只能有一个线程运行 synchronized(lock) 内的代码块,其他线程会否则阻塞。PS:获取锁(运行代码块),释放锁(阻塞代码块)

wait())的线程wait())的线程,注意:notify() 或 notifyAll() 必须等到退出 synchronized() 或 wait() 后才释放锁!

1

+2

+3

+4

+5

+6

+7

+8

+

synchronized (obj) {

+ // 条件不满足

+ while (condition does not hold) {

+ obj.wait();

+ }

+ // 执行满足条件的代码

+ obj.notifyAll();

+}

+

or

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+

synchronized (obj) {

+ while (true){

+ // 条件满足

+ if (condition holds){

+ // 执行满足条件的代码

+ obj.notifyAll();

+ }

+ obj.wait();

+ }

+}

+

+

synchronized 可以用来修饰非静态方法(普通方法)、静态方法、代码块,锁住的是 class 对象的对象头!

run() 和 start() 的区别:

Synchronized 和 Lock 的区别:

RenentantLock:

Java 中的线程分为两种:

集合框架:

线程安全的list:

为什么计算哈希值采用低十六位和高十六位异或操作:

计算数组下标是与操作,只有低 n 位进行与操作,高位不参与任何操作 -> 为了增大散列程度减小哈希碰撞,因此将高十六位参与进哈希值的计算。

put() 的流程:

扩容的过程:

Set:

NULL key AND NULL value:

为什么ConcureentHashMap的key和value都不能为null:

containsKey() 解决,但是多线程下无法使用同样的方法,因为可能会有其他线程进行其他操作影响返回值。ConcurrentHashMap JDK7 vs JDK8

HashTable速度慢:使用synchronized对整个对象加锁。

JDK7:对整个数组进行分段(每段都是由若干个 hashEntry 对象组成的链表),每个分段都有一个 Segment 分段锁(继承 ReentrantLock 分段锁)。与hashtable相比,加锁粒度更细,但是初始化Segment数组长度后就无法扩容。ConcurrentHashMap 是一个二级哈希表。在一个总的哈希表下面,有若干个子哈希表。

JDK8:对table数组的头节点加锁(哈希桶为空时,使用CAS将新的Node写入哈希桶的首节点;哈希桶不为空时,使用synchronized对首节点加锁接着添加节点)

ThreadLocal: 提供线程内的局部变量,在多线程的环境中保证各个线程内的变量不同。将数据封闭在线程中而避免使用同步,即线程封闭。一个ThreadLocal对象即是一个线程局部变量。jdbc连接池就是用ThreadLocal,典型例子。以下使四种方法:

底层是 ThreadLocalMap 内部静态类,由数组实现,解决 hash 冲突的方式采用的是线性探测法

存在内存泄漏的原因:由于 ThreadLocalMap 的生命周期跟 Thread 一样长,如果没有手动删除对应 key 就会导致该 key 的value 永远无法被访问,造成内存泄漏

正确使用方法:

线程池的七个参数:

核心线程数(corePoolSize): 核心线程数是线程池中保持活动状态的线程数。即使没有任务需要执行,核心线程也不会被回收。当有新任务提交时,如果核心线程都在忙碌,则会创建新的线程来处理任务。

最大线程数(maximumPoolSize): 最大线程数是线程池中允许的最大线程数。当工作队列满了并且活动线程数达到最大线程数时,如果还有新任务提交,线程池将创建新的线程来处理任务。但是,超过最大线程数的线程可能会导致资源消耗过大。

空闲线程存活时间(keepAliveTime): 空闲线程存活时间指的是非核心线程在没有任务执行时的最长存活时间。当线程池中的线程数超过核心线程数且空闲时间达到设定值时,多余的线程将被终止,直到线程池中的线程数不超过核心线程数。

时间单位(unit): 时间单位是用于表示核心线程数和空闲线程存活时间的单位。常见的时间单位包括秒、毫秒、分钟等。

工作队列(workQueue): 工作队列用于存储待执行的任务。当线程池中的线程都在忙碌时,新提交的任务将被添加到工作队列中等待执行。常见的工作队列类型有有界队列(如 ArrayBlockingQueue)和无界队列(如 LinkedBlockingQueue)等。

线程工厂(threadFactory): 线程工厂用于创建新线程。线程工厂提供了创建线程的方法,可以自定义线程的名称、优先级等属性。

JDK四种线程池:

线程池执行顺序:

简而言之:corePool->workQueue->maxPool

线程池被回收:线程池也是在堆中也是一个对象,一定要调用shutdown

线程池何时回收线程:getTask()的返回值为null时

核心线程数设置:

锁升级的过程:当有线程访问同步块时,无锁升级为偏向锁;当有锁竞争时,升级为轻量级锁;当自旋十次失败,升级为重量级锁。

Synchronized(同步锁):属于独占锁、悲观锁、可重入锁、非公平锁。

ReentrantLock:继承了Lock类,两者都是可重入锁、悲观锁、独占锁、默认非公平锁。

该类是一个抽象类,采用模板方法的设计模式,规定了独占和共享模式需要实现的方法。

简单解释:CAS修改volatile修饰的int值state(该值代表竞争资源标识) + 一个存放等待锁的线程队列。其定义了两种资源共享模式:

独占式。ReentrantLock 是独占式的锁资源。初始化 state = 0,表示资源未被锁定,调用 lock() 方法时state的值加一,并且当 state = 0 才表明其他线程有机会获取锁。

共享式。ReentrantWriteLock 和 CountDownLatch 是共享锁模式。CountDownLatch 会将任务分成 N 个子任务,初始化 state = N,每个子线程完成任务后会减一,直到为零。

Contract接口模式,结合feign实现

接口和抽象类的区别:

java中静态属性和静态方法可以被继承,但是不能被重写,因此不能实现多态。

静态常量/静态变量/静态方法是用static修饰的常量/变量/方法,其从属于类。另外,static是不允许用来修饰局部变量的。

静态方法可以调用静态变量,但不能调用非静态变量,因为静态方法在类加载时就分配了内存,而非静态变量是在对象实例化时才分配内存。

非静态方法可以调用静态变量,也可以调用非静态变量。

执行顺序:静态初始化块 > 初始化块 > 构造方法

非静态初始化块(构造代码块):

作用:给对象进行初始化。对象一建立就运行,且优先于构造函数的运行。

与构造函数的区别:

非静态初始化块给所有对象进行统一初始化,构造函数只给对应对象初始化。

应用:将所有构造函数共性的东西定义在构造代码块中。

静态初始化块:

作用:给类进行初始化。随着类的加载而执行,且只执行一次

与构造代码块的区别:

泛型:参数化类型,指在定义一个类、接口或者方法时可以指定类型参数。

泛型擦除:是指Java中的泛型只在编译期有效,在运行期间会被删除。也就是说所有泛型参数在编译后都会被清除掉。

在编译器编译后,泛型的转换规则如下:

java.lang.reflect.Proxy 中的动态代理java.util.Iterator 使用迭代器遍历集合容器acquire 和 release 方法被独占式和共享式所重写Topic 是逻辑概念,队列(Kafka 中叫分区)是物理概念。每个主题包含多个消息,每条消息只属于一个主题。一个 Producer 可以同时发送多种 Topic 的消息,而一个 Consumer 只能订阅一个 Topic 的消息。Tag 类似于子主题。

MessageQueue用于存储消息的物理地址,每个Topic中的消息地址存储于多个MessageQueue,是消息的最小存储单元。

整体区别是 Kafka 的设计初衷是用于日志传输,而 RocketMQ 是用于解决各类应用可靠的消息传输,适用于业务需求。

Kafka 采用partition,每个topic的每个partition对应一个文件。顺序写入,定时刷盘。但一旦单个broker的partition过多,则顺序写将退化为随机写,Page Cache脏页过多,频繁触发缺页中断,性能大幅下降。

RocketMQ 采用CommitLog + ConsumeQueue,物理存储文件是CommitLog,ConsumeQueue是消息的逻辑队列,类似数据库的索引文件,存储的是指向物理存储的地址。每个Topic下的每个MessageQueue都有一个对应的ConsumeQueue文件,单个broker所有topic在CommitLog中顺序写。每个CommitLog大小固定为1G。

生产消息:Producer 先向 CommitLog 顺序写,持久化后将数据 Dispatch 到 ConsumeQueue 中。 消费消息:Consumer 从 ConsumeQueue 中拉取数据,但拉取到数据是指向 CommitLog 的地址,此时是随机读,但又因为 PageCache 的存在,还是整体有序的。

Page Cache(页面缓存)从内存中划出一块区域缓存文件页,如果要访问外部磁盘上的文件页,首先将这些页面拷贝到内存中,再进行读写。

RocketMQ新增同步刷盘和同步复制机制,保证可靠性。而 Kafka 倾向于牺牲部分可靠性换取更高的性能(因为 Kafka 中的 producer 将信息堆起来一起发送,以减少网络IO,但是这个时候如果 producer 宕机了,会导致信息丢失的)。

异步刷盘:返回写成功状态时,消息可能只是被写进内存,吞吐量大,当内存大消息积累到一定程度时,统一触发写磁盘操作,快速写入。

同步刷盘:返回写成功状态时,消息已经被写入磁盘。流程是消息写入内存后,立刻通知刷盘线程刷盘,等待刷盘完成后再唤醒等待的线程返回消息写成功的状态。

异步复制:只要写就返回写成功状态。较低的延迟和较高的吞吐量。

同步复制:写成功后返回写成功状态。容易恢复故障的数据。

两者类似,都是从 Producer -> Broker -> Consumer 三个阶段逐一判断,只不过设置的参数不同。

Producer: 同步发送消息;超时重试发送;消息补偿机制(Kafka,超时仍失败的情况下,会继续投递到本地消息表,定时轮询并推送到Kafka);ACKs(Kafka中,该参数表示多少个副本收到消息,认为消息写入成功)

Broker: 同步刷盘;设置主从模式,配置副本

Consumer: At least Once 的消费机制;消费重试;ACK机制;手动提交位移(Kafka)

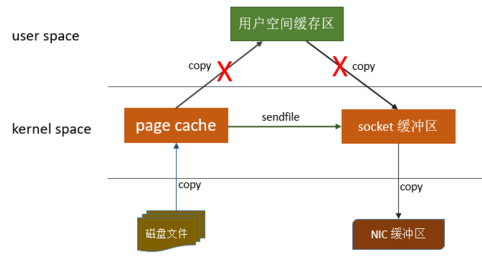

传统的数据传输过程通常需要经历多次内存拷贝。

首先,从磁盘读取数据,然后将数据从内核空间拷贝到用户空间,再从用户空间拷贝到应用程序的内存中。这些额外的拷贝会消耗大量的CPU资源和内存带宽,降低数据传输的效率。零拷贝就是为了避免这些不必要的数据拷贝,能够将数据直接传输到目标内存区域,以提高数据传输的效率。

实现方式

零拷贝技术减少了用户进程地址空间和内核地址空间之间由于上下文切换而带来的开销。DMA (Direct Memory Access) 是零拷贝技术的基石。并不是不需要拷贝,而是减少冗余不必要的拷贝。

为什么 Kafka 这么快?

答:六个要点,顺序读写、零拷贝、消息压缩、分批读写/发送、基于操作系统内存PageCache的读写、分区分段 + 索引。

为什么 RocketMQ 这么快?

答:顺序写,零拷贝,异步刷盘(先写入操作系统的PageCache再异步刷盘到磁盘)

RocketMQ 的消费重试是基于延迟消息实现的,在消息消费失败的情况下,重新当作延迟消息投递到 Broker 中,并且延迟等级逐渐增加,消息重试会有 16 个级别,恰好是延迟消息的 18 个级别的后 16 个级别。

主要分为以下几步,类似于流转:

基于 时间轮 算法(类似于钟表):存储定时任务的环形队列,底层采用数组实现,数组中的每个元素可以存放一个定时任务列表。每隔一个时间跨度,下标移动一次。

二阶段:第一阶段发送 prepared 消息,接着执行本地事务,第二阶段发送 commit 或 rollback 的消息。

定时回查:定时遍历 commitlog 中的半事务消息

如果事务正常执行,则 commit 该消息,如果抛出异常,则 rollback。对于消费消息失败,RocketMQ 会尝试重新消费,直到被加入死信队列中为止。在重试的过程中有可能产生重复的消息,所以对于消费端来说要确保消费幂等!

原因可能是以下三种:

处理堆积的消息:建立临时的 topic(扩容),转发堆积的消息

RocketMQ:topic 可以达到几百/几千的级别,吞吐量会有较小幅度的下降,这是 RocketMQ 的一大优势,在同等机器下,可以支撑大量的 topic

Kafka:topic 从几十到几百个时候,吞吐量会大幅度下降。原理:Kafka 利用操作系统的 PageCache 先将消息持久化到内存中,并不是直接写入磁盘。Topic 增加,也就是 Partition 数量会增加,使用的 PageCache 也会大量增加,大量增加后需要使用 LRU 淘汰算法对 Page 内容刷新到磁盘中,导致性能会下降。

分为两步:生产者有序存储,消费者有序消费。

针对消息有序的业务需求,还分为全局有序和局部有序。已知,每个partition的消费是顺序性的,但每个topic可以有若干个partition。

全局有序:一个Topic下的所有消息都需要按照生产顺序消费。

解决方法:1个Topic只能对应1个Partition。

局部有序:一个Topic下的消息,只需要满足同一业务字段的要按照生产顺序消费。例如:Topic消息是订单的流水表,包含订单orderId,业务要求同一个orderId的消息需要按照生产顺序进行消费。

解决方法:要满足局部有序,只需要在发消息的时候指定Partition Key,Partition Key相同的消息会放在同一个Partition。

全局有序:对于指定的一个 Topic,设置读写队列的数量为一。(与Kafka设置一个partition类似) 局部有序:对于指定的一个 Topic,生产者根据 hashKey 将消息发送到同一个MessageQueue。 同一个分区内的消息按照严格的 FIFO 顺序进行发布和消费。

实现消息有序性从三个方面:

主写主读,不支持读写分离

当 key 不存在时,会从当前存活的分区中轮询;当 key 存在时,发送给哈希后的指定分区。

Kafka 中主题订阅者的基本单位是消费者组,每个分区只能由消费者组中的一个消费者进行消费,多个消费者组之间对于分区的消费互不影响。共有三个分区分配器:

Producer 默认采用轮询的方法,按顺序将消息发送到 MessageQueue 里。

Kafka:适用于日志收集与分析、实时流处理、大数据集成(例如 Apache Storm 或 Flink)、用户行为追踪等场景。 RocketMQ:更适合金融交易、订单处理、秒杀活动、库存同步、跨系统间的服务解耦和异步调用等场景,尤其是那些对消息顺序、事务完整性和实时性要求极高的业务。

消费者组是一组共享 group.id 的消费者实例,一个消费者组可以消费多个 Topic 的消息,组内的消费者只能订阅相同的 Topic 和相同的 Tag 且 Tag 顺序相同。详见订阅关系一致。

RocketMQ/Kafka 使用 Consumer Group 机制,实现了传统两大消息引擎。如果所有实例属于同一个Group,那么它实现的就是消息队列模型;如果所有实例分别属于不同的Group,且订阅了相同的主题,那么它就实现了发布/订阅模型;

一个Topic分为多个Partition,一个Partition分为多个Segment。每个Segment对应三个文件:偏移量索引文件、时间戳索引文件、消息存储文件

在消息发送的过程中,涉及到两个线程,main线程和sender线程,其中main线程是消息的生产线程,而sender线程是jvm单例的线程,专门用于消息的发送。在jvm的内存中开辟了一块缓存空间叫RecordAccumulator(消息累加器),用于将多条消息合并成一个批次,然后由sender线程发送给kafka集群。

Kafka 采用 Pull 的方式,每个 Consumer 维护一个 HW 水位信息

Thread per consumer model:即每个线程都有自己的consumer实例,然后在一个线程里面完成数据的获取(pull)、处理(process)、offset提交。

Producer 发送压缩消息到 Broker 后,Broker 会保存压缩数据,由Consumer 解压数据。

Controller 用于在 ZK 的帮助下管理和协调整个 Kafka 集群。集群内任意一台 Broker 都能充当 Controller 的角色,但在运行过程中,只有一个 Controller。

利用labelme制作coco格式的实例分割数据集,该数据集适用于mmdetection2.0中的mask部分。

在mmdetection2.0框架下,利用coco格式的数据集进行实例分割默认只需要train2017和val2017两部分(当然也可以将test中的目录修改成test2017,但没必要)。

mmdetection2.0框架下coco格式数据集文件如下图放置:(运行完本文的.py文件后即可生成以下文件夹)

数据集标注方式:

当一张图片里没有多个同类别的物体,使用car,computer,bottle等标签直接进行标注;当一张图片里同个类别有多个物体时,标签采用sofa-1,sofa-2,desk-1,desk-2等标签-数字的格式进行标注;如果同一物体在遮挡情况下被分为多个部分,则不同部分都用同一个标签(具体如下图所示,牙膏的三个部分标签均为toothpaste)。

最后得到的json文件里的segmentation是分为三部分,bbox只存在一个(在笔者找的其他资料里,都是分为三个独立的牙膏部分,得到三个segmentation以及三个相应的bbox,显然不符合实际情况)。

建议在使用labelme进行对数据集标注时,将生成的.json文件放置在与数据集相同的路径下以避免一些不必要的麻烦。即下图:

否则,生成的json文件里的imagePath可能出现下图所示的情况:

如果实在是没办法,没有在同一路径下,imagePath会比较复杂(可能是windows系统用\分隔号,ubuntu系统则会是/分隔号,这一点是笔者的猜测),根据不同的情况修改后文代码。

各文件夹布局如下所示:

所有的.jpg文件放在images文件夹下,所有的.json文件(labelme标注完成后生成的文件)放在labelme/total2017文件夹下。

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+27

+28

+29

+30

+31

+32

+33

+34

+35

+36

+37

+38

+

# !/usr/bin/python

+# -*- coding: utf-8 -*-

+import os

+import random

+

+trainval_percent = 1 # No test sample

+train_percent = 0.9

+jsonfilepath = 'labelme/total2017'

+txtsavepath = './'

+total_xml = os.listdir(jsonfilepath)

+

+num = len(total_xml)

+list = range(num)

+tv = int(num * trainval_percent)

+tr = int(tv * train_percent)

+trainval = random.sample(list, tv)

+train = random.sample(trainval, tr)

+

+ftrainval = open('./trainval2017.txt', 'w')

+ftrain = open('./train2017.txt', 'w')

+fval = open('./val2017.txt', 'w')

+ftest = open('./test2017.txt', 'w') #Still create test2017.txt

+

+for i in list:

+ name = total_xml[i][:-5] + '\n'

+ if i in trainval:

+ ftrainval.write(name)

+ if i in train:

+ ftrain.write(name)

+ else:

+ fval.write(name)

+ else:

+ ftest.write(name)

+ftrainval.close()

+ftrain.close()

+fval.close()

+ftest.close()

+print('Create_txt Done')

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+

import shutil

+import os

+import os.path as osp

+

+sets=['train2017', 'val2017', 'test2017']

+for image_set in sets:

+ if osp.exists(image_set):

+ shutil.rmtree(image_set)

+ print('Deleted previous %s file and created a new one'%(image_set))

+ os.makedirs(image_set)

+ json_path = 'labelme/%s'%(image_set)

+ if osp.exists(json_path):

+ shutil.rmtree(json_path)

+ print('Deleted previous %s file and created a new one' % (json_path))

+ os.makedirs(json_path)

+ image_ids = open('./%s.txt'%(image_set)).read().strip().split()

+ for image_id in image_ids:

+ img = 'images/%s.jpg' % (image_id)

+ json = 'labelme/total2017/%s.json'% (image_id)

+ shutil.copy(img,image_set)

+ shutil.copy(json,'labelme/%s/'% (image_set))

+print("Done")

+

1

+2

+3

+4

+5

+6

+7

+8

+9

+10

+11

+12

+13

+14

+15

+16

+17

+18

+19

+20

+21

+22

+23

+24

+25

+26

+27

+28

+29

+30

+31

+32

+33

+34

+35

+36

+37

+38

+39

+40

+41

+42

+43

+44

+45

+46

+47

+48

+49

+50

+51

+52

+53

+54

+55

+56

+57

+58

+59

+60

+61

+62

+63

+64

+65

+66

+67

+68

+69

+70

+71

+72

+73

+74

+75

+76

+77

+78

+79

+80

+81

+82

+83

+84

+85

+86

+87

+88

+89

+90

+91

+92

+93

+94

+95

+96

+97

+98

+99

+100

+101

+102

+103

+104

+105

+106

+107

+108

+109

+110

+111

+112

+113

+114

+115

+116

+117

+118

+119

+120

+121

+122

+123

+124

+125

+126

+127

+128

+129

+130

+

#!/usr/bin/env python

+import collections

+import datetime

+import glob

+import json

+import os

+import os.path as osp

+import sys

+import numpy as np

+import PIL.Image

+import labelme

+import shutil

+

+try:

+ import pycocotools.mask

+except ImportError:

+ print('Please install pycocotools:\n\n pip install pycocotools\n')

+ sys.exit(1)

+

+

+def main():

+ sets = ['train2017','val2017','test2017']

+ output_dir = './annotations'

+ if osp.exists(output_dir):

+ print('Output directory already exists:', output_dir)

+ shutil.rmtree(output_dir)

+ os.makedirs(output_dir)

+ print('Creating dataset:', output_dir)

+ for set in sets:

+ input_dir = './labelme/%s'%(set)

+ filename = 'instances_%s'%(set)

+ now = datetime.datetime.now()

+ data = dict(

+ info=dict(

+ description=None,

+ version=None,

+ contributor=None,

+ date_created=now.strftime('%Y-%m-%d %H:%M:%S.%f'),

+ ),

+ licenses=[dict(

+ id=0,

+ name=None,

+ )],

+ images=[

+ # license, url, file_name, height, width, date_captured, id

+ ],

+ type='instances',

+ annotations=[

+ # segmentation, area, iscrowd, image_id, bbox, category_id, id

+ ],

+ categories=[

+ # supercategory, id, name

+ ],

+ )

+

+ class_name_to_id = {}

+ for i, line in enumerate(open('labels.txt').readlines()):

+ class_id = i - 1 # starts with -1

+ class_name = line.strip()

+ if class_id == -1:

+ assert class_name == '__ignore__'

+ continue

+ class_name_to_id[class_name] = class_id

+ data['categories'].append(dict(

+ supercategory=None,

+ id=class_id,

+ name=class_name,

+ ))

+ out_ann_file = osp.join(output_dir, filename+'.json')

+ label_files = glob.glob(osp.join(input_dir, '*.json'))

+ for image_id, label_file in enumerate(label_files):

+ with open(label_file) as f:

+ label_data = json.load(f)

+ path=label_data['imagePath'].split("\\") # 可能因为windows或ubuntu不同的系统用\\或/划分,详见前言三

+ img_file = './%s/'%(set) + path[-1]

+ img = np.asarray(PIL.Image.open(img_file))

+ data['images'].append(dict(

+ license=0,

+ url=None,

+ file_name=label_file.split('/')[-1].split('.')[0] + '.jpg',

+ height=img.shape[0],

+ width=img.shape[1],

+ date_captured=None,

+ id=image_id,

+ ))

+ masks = {} # for area

+ segmentations = collections.defaultdict(list) # for segmentation

+ for shape in label_data['shapes']:

+ points = shape['points']

+ label = shape['label']

+ shape_type = shape.get('shape_type', None)

+ mask = labelme.utils.shape_to_mask(

+ img.shape[:2], points, shape_type

+ )

+

+ if label in masks:

+ masks[label] = masks[label] | mask

+ else:

+ masks[label] = mask

+

+ points = np.asarray(points).flatten().tolist()

+ segmentations[label].append(points)

+

+ for label, mask in masks.items():

+ cls_name = label.split('-')[0]

+ if cls_name not in class_name_to_id:

+ continue

+ cls_id = class_name_to_id[cls_name]

+

+ mask = np.asfortranarray(mask.astype(np.uint8))

+ mask = pycocotools.mask.encode(mask)

+ area = float(pycocotools.mask.area(mask))

+ bbox = pycocotools.mask.toBbox(mask).flatten().tolist()

+

+ data['annotations'].append(dict(

+ id=len(data['annotations']),

+ image_id=image_id,

+ category_id=cls_id,

+ segmentation=segmentations[label],

+ area=area,

+ bbox=bbox,

+ iscrowd=0,

+ ))

+

+ with open(out_ann_file, 'w') as f:

+ json.dump(data, f,indent=4)

+ print(set + ' is done')

+

+if __name__ == '__main__':

+ main()

+

上述三个文件按顺序执行即可。

最后所有的文件夹如下图所示,如前文所提到的,在mmdetection中被利用到的只有annotations,train2017,val2017三个文件夹。

本文的代码可以反复运行,因为代码中包含一些旧文件夹的删除以及新建,不会报错。

MathJax中的公式排版有两种方式,inline和displayed。

inline表示公式嵌入到文本段中,也称为行模式。$ f(x) = 3 \times x $这是一个inline公式

displayed表示公式独自成为一个段落,也成为块模式。下面则是一个displayed公式。

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\pm$ | \pm | $\mp$ | \mp | $\times$ | \times |

| $\div$ | \div | $\cdot$ | \cdot | $\ast$ | \ast |

| $\star$ | \star | $\dagger$ | \dagger | $\ddagger$ | \ddagger |

| $\amalg$ | \amalg | $\cap$ | \cap | $\cup$ | \cup |

| $\uplus$ | \uplus | $\sqcap$ | \sqcap | $\sqcup$ | \sqcup |

| $\vee$ | \vee | $\wedge$ | \wedge | $\oplus$ | \oplus |

| $\ominus$ | \ominus | $\otimes$ | \otimes | $\circ$ | \circ |

| $\bullet$ | \bullet | $\diamond$ | \diamond | $\lhd$ | \lhd |

| $\rhd$ | \rhd | $\unlhd$ | \unlhd | $\unrhd$ | \unrhd |

| $\oslash$ | \oslash | $\odot$ | \odot | $\bigcirc$ | \bigcirc |

| $\triangleleft$ | \triangleleft | $\Diamond$ | \Diamond | $\bigtriangleup$ | \bigtriangleup |

| $\bigtriangledown$ | \bigtriangledown | $\Box$ | \Box | $\triangleright$ | \triangleright |

| $\setminus$ | \setminus | $\wr$ | \wr | $\sqrt{x}$ | \sqrt{x} |

| $x^{\circ}$ | x^{\circ} | $\triangledown$ | \triangledown | $\sqrt[n]{x}$ | \sqrt[n]{x} |

| $a^x$ | a^x | $a^{xyz}$ | a^{xyz} | $\frac{x}{y}$ | \frac{x}{y} |

| $\sin{x}$ | \sin{x} | $\cos{x}$ | \cos{x} | $\tan{x}$ | \tan{x} |

| $\log_xy$ | \log_xy | $\ln{x}$ | \ln{x} | $\max(x,y,z)$ | \max(x,y,z) |

\sum\limits_{i=0}^n{a_i} 显示为$\sum\limits_{i=0}^n{a_i}$\prod\limits_{i=0}^n{\frac{1}{i^2}} 显示为$\prod\limits_{i=0}^n{\frac{1}{i^2}}$\int_0^xf(x)dx显示为$\int_0^xf(x)dx$\lim\limits_{x\to 0}{x} 显示为$\lim\limits_{x\to 0}{x}$\mathop{SUPER}\limits_{i=0}^n{i^2} 显示为$\mathop{SUPER}\limits_{i=0}^n{i^2}$| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\le $ | \le | $\ge $ | \ge | $\neq $ | \neq |

| $\sim $ | \sim | $\ll $ | \ll | $\gg $ | \gg |

| $\doteq $ | \doteq | $\simeq $ | \simeq | $\subset $ | \subset |

| $\supset $ | \supset | $\approx $ | \approx | $\asymp $ | \asymp |

| $\subseteq $ | \subseteq | $\supseteq $ | \supseteq | $\cong $ | \cong |

| $\smile $ | \smile | $\sqsubset $ | \sqsubset | $\sqsupset $ | \sqsupset |

| $\equiv $ | \equiv | $\frown $ | \frown | $\sqsubseteq $ | \sqsubseteq |

| $\sqsupseteq$ | \sqsupseteq | $\propto $ | \propto | $\bowtie $ | \bowtie |

| $\in $ | \in | $\ni $ | \ni | $\prec $ | \prec |

| $\succ $ | \succ | $\vdash $ | \vdash | $\dashv $ | \dashv |

| $\preceq $ | \preceq | $\succeq $ | \succeq | $\models $ | \models |

| $\perp $ | \perp | $\parallel $ | \parallel | ||

| $\mid $ | \mid | $\bumpeq $ | \bumpeq |

上面这些关系符号的否定(反义)形式可以通过在原符号前添加 \not 来进行实现,或者在 \ 和符号单词之间添加 n 来实现。

下面列出几个常用的否定形式,其他符号的否定形式规则基本类似。

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\nmid $ | \nmid | $\nleq $ | \nleq | $\ngeq $ | \ngeq |

| $\nsim $ | \nsim | $\ncong $ | \ncong | $\nparallel $ | \nparallel |

| $\not< $ | \not< | $\not> $ | \not> | $\not= $ | \not= |

| $\not\le $ | \not\le | $\not\ge $ | \not\ge | $\not\sim $ | \not\sim |

| $\not\approx $ | \not\approx | $\not\cong $ | \not\cong | $\not\equiv $ | \not\equiv |

| $\not\parallel $ | \not\parallel | $\nless $ | \nless | $\ngtr $ | \ngtr |

| $\lneq $ | \lneq | $\gneq $ | \gneq | $\lnsim $ | \lnsim |

| $\lneqq $ | \lneqq | $\gneqq $ | \gneqq |

像 =, >, 和 < 并没有列在上面的符号,可以直接字面输入,并不需要命令进行触发。

小写:

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\alpha $ | \alpha | $ \beta $ | \beta | $\gamma $ | \gamma |

| $\epsilon $ | \epsilon | $ \varepsilon $ | \varepsilon | $\zeta $ | \zeta |

| $\theta $ | \theta | $ \vartheta $ | \vartheta | $\iota $ | \iota |

| $\lambda $ | \lambda | $ \mu $ | \mu | $\nu $ | \nu |

| $\pi $ | \pi | $ \varpi $ | \varpi | $\rho $ | \rho |

| $\sigma $ | \sigma | $ \varsigma $ | \varsigma | $\tau $ | \tau |

| $\phi $ | \phi | $ \varphi $ | \varphi | $\chi $ | \chi |

| $\omega $ | \omega | $ \varrho $ | \varrho | $\kappa $ | \kappa |

| $\delta $ | \delta | $ \upsilon $ | \upsilon | $\xi $ | \xi |

| $\eta $ | \eta | $ \psi $ | \psi |

大写:

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\Gamma $ | \Gamma | $\Delta $ | \Delta | $ \Theta $ | \Theta |

| $\Xi $ | \Xi | $\Pi $ | \Pi | $ \Sigma $ | \Sigma |

| $\Phi $ | \Phi | $\Psi $ | \Psi | $ \Omega $ | \Omega |

| $\Lambda $ | \Lambda | $\Upsilon $ | \Upsilon |

斜体大写:

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\varGamma $ | \varGamma | $\varDelta $ | \varDelta | $ \varTheta $ | \varTheta |

| $\varXi $ | \varXi | $\varPi $ | \varPi | $ \varSigma $ | \varSigma |

| $\varPhi $ | \varPhi | $\varPsi $ | \varPsi | $ \varOmega $ | \varOmega |

| $\varLambda $ | \varLambda | $\varUpsilon $ | \varUpsilon |

| Symbol | Command | Symbol | Command |

|---|---|---|---|

| $\gets $ | \gets | $\to $ | \to |

| $\leftarrow $ | \leftarrow | $\Leftarrow $ | \Leftarrow |

| $\rightarrow $ | \rightarrow | $\Rightarrow $ | \Rightarrow |

| $\leftrightarrow $ | \leftrightarrow | $\Leftrightarrow $ | \Leftrightarrow |

| $\mapsto $ | \mapsto | $\hookleftarrow $ | \hookleftarrow |

| $\leftharpoonup $ | \leftharpoonup | $\leftharpoondown $ | \leftharpoondown |

| $\rightleftharpoons $ | \rightleftharpoons | $\longleftarrow $ | \longleftarrow |

| $\Longleftarrow $ | \Longleftarrow | $\longrightarrow $ | \longrightarrow |

| $\Longrightarrow $ | \Longrightarrow | $\longleftrightarrow$ | \longleftrightarrow |

| $\Longleftrightarrow $ | \Longleftrightarrow | $\longmapsto $ | \longmapsto |

| $\hookrightarrow $ | \hookrightarrow | $\rightharpoonup $ | \rightharpoonup |

| $\rightharpoondown $ | \rightharpoondown | $\leadsto $ | \leadsto |

| $\uparrow $ | \uparrow | $\Uparrow $ | \Uparrow |

| $\downarrow $ | \downarrow | $\Downarrow $ | \Downarrow |

| $\updownarrow $ | \updownarrow | $\Updownarrow $ | \Updownarrow |

| $\nearrow $ | \nearrow | $\searrow $ | \searrow |

| $\swarrow $ | \swarrow | $\nwarrow $ | \nwarrow |

有些箭头指令, mathjax 提供了缩写指令, $\iff$(\iff) 和 $\implies$(\implies) 可以分别表示为 $\Longleftrightarrow$(\Longleftrightarrow) 和 $\Longrightarrow$(\Longrightarrow)

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\hat{x} $ | \hat{x} | $\check{x} $ | \check{x} | $\dot{x} $ | \dot{x} |

| $\breve{x}$ | \breve{x} | $\acute{x} $ | \acute{x} | $\ddot{x} $ | \ddot{x} |

| $\grave{x}$ | \grave{x} | $\tilde{x} $ | \tilde{x} | $\mathring{x} $ | \mathring{x} |

| $\bar{x} $ | \bar{x} | $\vec{x} $ | \vec{x} | $\overline{x} $ | \overline{x} |

| $\widehat{7+x}$ | \widehat{7+x} | $\widetilde{abc}$ | \widetilde{abc} |

\tilde 和 \hat 两个指令有宽符号的版本。

上述表格最后一行,\widetilde 和 \widehat,通过这两个指令可以生成长版本的表达式结构的符号。

1

+2

+3

+4

+5

+6

+7

+

$$

+f(n) = \tag{1}

+\begin{cases}

+\frac{a_n^3}{2}, & \text{if $n$ is even} \\

+3a_n^2+1, & \text{if $n$ is odd}

+\end{cases}

+$$

+

\mathtt{R} 显示为$\mathtt{R}$\mathbb{R} 显示为$\mathbb{R}$。表示实数集的意思。\mathsf{R} 显示为$\mathsf{R}$\mathscr{R} 显示为$\mathscr{R}$\mathrm{R} 显示为$\mathrm{R}$| Symbol | Command | Symbol | Command |

|---|---|---|---|

| $\cdot $ | \cdot | $\vdots $ | \vdots |

| $\dots $ | \dots | $\ddots $ | \ddots |

| $\cdots$ | \cdots | $\ldots $ | \ldots |

\ldots 和 \cdots 是低位置省略号和中心位置省略号的 latex 命令, \dots 是 amsmath 命令用来试图帮你在 \ldots 和 \cdots 中自动做决断的。

通常来讲中心省略 \cdots 一般用在数学模式的中心线上的符号后面,例如加号 + 或者右箭头 -> , 而 \ldots 一般用在标点符号的后面,例如句号“ . ” or逗号“ , ”。

例如,

$ a + b + \cdots + z \quad a_1, \ldots, a_n $ 显示为$ a + b + \cdots + z \quad a_1, \ldots, a_n $

改为\dots便可以根据实际情况自动地改变省略号的位置

$ a + b + \dots + z \quad a_1, \dots, a_n $ 显示为$ a + b + \dots + z \quad a_1, \dots, a_n $

使用\dots基本可以满足要求。但是,\dots 并不是每次都能正确自动改变省略号的位置,所以还是需要根据自己的实际情况选择不同的dots。

1

+2

+3

+4

+5

+6

+7

+8

+

$$

+\begin{bmatrix}

+{a_{11}}&{a_{12}}&{\cdots}&{a_{1n}}\\

+{a_{21}}&{a_{22}}&{\cdots}&{a_{2n}}\\

+{\vdots}&{\vdots}&{\ddots}&{\vdots}\\

+{a_{m1}}&{a_{m2}}&{\cdots}&{a_{mn}}\\

+\end{bmatrix}

+$$

+

在数学公式里,有时我们会通过括号( (), [], {} )进行界线控制。这些符号有些是可以直接输入,比如 (), [], | 等,而有些符号是要经过转义的,下面列出了这些比较特殊的符号。

| Symbol | Command | Symbol | Command |

|---|---|---|---|

| $\lfloor $ | \lfloor | $\rfloor $ | \rfloor |

| $\lceil $ | \lceil | $\rceil $ | \rceil |

| $\langle $ | \langle | $\rangle $ | \rangle |

上括号$ \overbrace{a_0+a_1+a_2+\cdots+a_n}^{x} $,显示为$ \overbrace{a_0+a_1+a_2+\cdots+a_n}^{x} $

下括号$ \underbrace{a_0+a_1+a_2+\cdots+a_n}_{x} $,显示为$ \underbrace{a_0+a_1+a_2+\cdots+a_n}_{x} $

但是有时候界限符号不够高,所以需要一些自适应括号,比如$ (\frac{a}{x} )^2 $,显示为

使用自适应括号的代码为$ \left(\frac{a}{x} \right)^2 $,显示为

但是也只有在块模式的时候会比较明显。

| Symbol | Command | Symbol | Command | Symbol | Command |

|---|---|---|---|---|---|

| $\infty $ | \infty | $ \triangle $ | \triangle | $\angle $ | \angle |

| $\aleph $ | \aleph | $ \hbar $ | \hbar | $\imath $ | \imath |

| $\jmath $ | \jmath | $ \ell $ | \ell | $\wp $ | \wp |

| $\Re $ | \Re | $ \Im $ | \Im | $\mho $ | \mho |

| $\prime $ | \prime | $ \emptyset $ | \emptyset | $\nabla $ | \nabla |

| $\surd $ | \surd | $ \partial $ | \partial | $\top $ | \top |

| $\bot $ | \bot | $ \vdash $ | \vdash | $\dashv $ | \dashv |

| $\forall $ | \forall | $ \exists $ | \exists | $\neg $ | \neg |

| $\flat $ | \flat | $ \natural $ | \natural | $\sharp $ | \sharp |

| $\backslash$ | \backslash | $ \Box $ | \Box | $\Diamond $ | \Diamond |

| $\clubsuit $ | \clubsuit | $ \diamondsuit $ | \diamondsuit | $\heartsuit $ | \heartsuit |

| $\spadesuit$ | \spadesuit | $ \Join $ | \Join | $\blacksquare$ | \blacksquare |

| $\bigstar $ | \bigstar | $ \in $ | \in | $\cup $ | \cup |

| $\square $ | \square | $ \S $ | \S | $\checkmark $ | \checkmark |

| $\because $ | \because | $ \therefore $ | \therefore |

两个独立的仓库A、B,将仓库B合并至仓库A的分支,并保留A、B的所有commits

例如:将dumped-CompetitiveLin.github.io中的所有提交内容合并至CompetitiveLin.github.io的another分支。

1

+

git clone git@github.com:CompetitiveLin/CompetitiveLin.github.io

+

1

+

git remote add base git@github.com:CompetitiveLin/dumped-CompetitiveLin.github.io

+

此时查看remote: git remote -v,如下图所示:

如果需要删除remote: git remote rm base

1

+

git fetch base

+

1

+

git checkout -b another base/dumped

+

查看branch分支:git branch

1

+

git checkout main

+

1

+

git merge another

+

此时可能出现类似下图fatal: refusing to merge unrelated histories的报错信息。

解决方法:

1

+

git merge another --allow-unrelated-histories

+

在合并时有可能两个分支对同一个文件都做了修改,这时需要解决冲突1,在windows下可以使用Github Desktop解决冲突问题。

1

+

git push origin another

+

原因:没有配置ssh-key,没有权限2

解决方法:

1

+2

+

ssh-keygen -t rsa -b 4096 -C "your_email@example.com"

+ clip < ~/.ssh/id_rsa.pub

+

See here.

单机 QPS 为 4k 左右。

* 拓展为表上的所有列。组成:段(默认256MB) -> 区(默认1MB) -> 页(默认16KB) -> 行

页:InnoDB的数据按页为单位读写,默认每个页大小为16KB,意味着一次最少从磁盘读取16KB的内容到内存中,一次最少把内存中的16KB内容刷新到磁盘中。表中的记录存储在数据页中。B+树的每个节点都是一个数据页。

区:数据量大的时候,索引分配空间则是按区为单位分配,每个区的大小为1MB,对于16KB的页来说,连续(物理连续)64个页会被划分到一个区,这样,B+树中节点所构成的链表中相邻页的物理位置也相邻,便能顺序IO。

段:段是数据库中的分配单位,不同类型的数据库对象以不同的段形式存在。当创建数据表、索引的时候,就会相应创建对应的段,比如创建一张表时会创建一个表段,创建一个索引时会创建一个索引段。在段中不要求区与区之间是相邻的。

数据页都是以双向链表的形式存在,如果以页分配存储空间,双向链表相邻的两个页之间的物理位置可能距离非常远,会产生随机 IO,影响性能

对于范围查询,本质是对B+树叶子节点中的记录进行顺序扫描,但如果不区分叶子节点和非叶子节点,把节点代表的页都申请到区中,范围查找效率大打折扣。一个索引会产生两个段,一个叶子节点段(数据段)和一个非叶子节点段(索引段)。