表示 如果特征向量 v 被某个矩阵 A 左乘,那么它就等于某个标量 入 乘以 v.

-幸运的是: Numpy 中有寻找特征向量和特征值的模块 linalg,它有 eig() 方法,该方法用于求解特征向量和特征值。 +幸运的是: Numpy 中有寻找特征向量和特征值的模块 linalg,它有 eig() 方法,该方法用于求解特征向量和特征值。 ```python def pca(dataMat, topNfeat=9999999): @@ -158,9 +158,9 @@ def pca(dataMat, topNfeat=9999999): # cov协方差=[(x1-x均值)*(y1-y均值)+(x2-x均值)*(y2-y均值)+...+(xn-x均值)*(yn-y均值)+]/(n-1) ''' - 方差:(一维)度量两个随机变量关系的统计量 - 协方差: (二维)度量各个维度偏离其均值的程度 - 协方差矩阵:(多维)度量各个维度偏离其均值的程度 + 方差: (一维)度量两个随机变量关系的统计量 + 协方差: (二维)度量各个维度偏离其均值的程度 + 协方差矩阵: (多维)度量各个维度偏离其均值的程度 当 cov(X, Y)>0时,表明X与Y正相关;(X越大,Y也越大;X越小Y,也越小。这种情况,我们称为“正相关”。) 当 cov(X, Y)<0时,表明X与Y负相关; @@ -212,7 +212,7 @@ def pca(dataMat, topNfeat=9999999): ``` 降维技术使得数据变的更易使用,并且它们往往能够去除数据中的噪音,使得其他机器学习任务更加精确。 降维往往作为预处理步骤,在数据应用到其他算法之前清洗数据。 -比较流行的降维技术: 独立成分分析、因子分析 和 主成分分析, 其中又以主成分分析应用最广泛。 +比较流行的降维技术: 独立成分分析、因子分析 和 主成分分析, 其中又以主成分分析应用最广泛。 本章中的PCA将所有的数据集都调入了内存,如果无法做到,就需要其他的方法来寻找其特征值。 如果使用在线PCA分析的方法,你可以参考一篇优秀的论文 "Incremental Eigenanalysis for Classification"。 @@ -221,6 +221,6 @@ def pca(dataMat, topNfeat=9999999): * * * -* **作者:[片刻](http://cwiki.apachecn.org/display/~jiangzhonglian) [1988](http://cwiki.apachecn.org/display/~lihuisong)** +* **作者: [片刻](http://cwiki.apachecn.org/display/~jiangzhonglian) [1988](http://cwiki.apachecn.org/display/~lihuisong)** * [GitHub地址](https://github.com/apachecn/AiLearning):

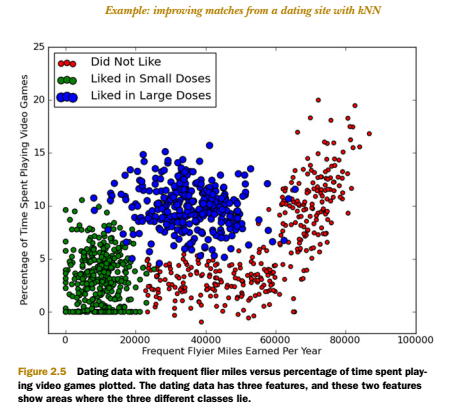

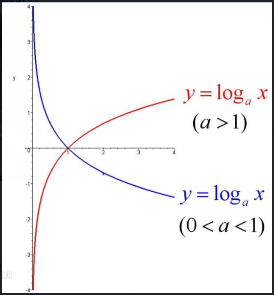

-1. 动作片:打斗次数更多 -2. 爱情片:亲吻次数更多 +1. 动作片: 打斗次数更多 +2. 爱情片: 亲吻次数更多 基于电影中的亲吻、打斗出现的次数,使用 k-近邻算法构造程序,就可以自动划分电影的题材类型。 @@ -47,20 +47,20 @@ knn 算法按照距离最近的三部电影的类型,决定未知电影的类 > KNN 开发流程 ``` -收集数据:任何方法 -准备数据:距离计算所需要的数值,最好是结构化的数据格式 -分析数据:任何方法 -训练算法:此步骤不适用于 k-近邻算法 -测试算法:计算错误率 -使用算法:输入样本数据和结构化的输出结果,然后运行 k-近邻算法判断输入数据分类属于哪个分类,最后对计算出的分类执行后续处理 +收集数据: 任何方法 +准备数据: 距离计算所需要的数值,最好是结构化的数据格式 +分析数据: 任何方法 +训练算法: 此步骤不适用于 k-近邻算法 +测试算法: 计算错误率 +使用算法: 输入样本数据和结构化的输出结果,然后运行 k-近邻算法判断输入数据分类属于哪个分类,最后对计算出的分类执行后续处理 ``` > KNN 算法特点 ``` -优点:精度高、对异常值不敏感、无数据输入假定 -缺点:计算复杂度高、空间复杂度高 -适用数据范围:数值型和标称型 +优点: 精度高、对异常值不敏感、无数据输入假定 +缺点: 计算复杂度高、空间复杂度高 +适用数据范围: 数值型和标称型 ``` ## KNN 项目案例 @@ -76,7 +76,7 @@ knn 算法按照距离最近的三部电影的类型,决定未知电影的类 * 魅力一般的人 * 极具魅力的人 -她希望: +她希望: 1. 工作日与魅力一般的人约会 2. 周末与极具魅力的人约会 3. 不喜欢的人则直接排除掉 @@ -86,25 +86,25 @@ knn 算法按照距离最近的三部电影的类型,决定未知电影的类 #### 开发流程 ``` -收集数据:提供文本文件 -准备数据:使用 Python 解析文本文件 -分析数据:使用 Matplotlib 画二维散点图 -训练算法:此步骤不适用于 k-近邻算法 -测试算法:使用海伦提供的部分数据作为测试样本。 - 测试样本和非测试样本的区别在于: +收集数据: 提供文本文件 +准备数据: 使用 Python 解析文本文件 +分析数据: 使用 Matplotlib 画二维散点图 +训练算法: 此步骤不适用于 k-近邻算法 +测试算法: 使用海伦提供的部分数据作为测试样本。 + 测试样本和非测试样本的区别在于: 测试样本是已经完成分类的数据,如果预测分类与实际类别不同,则标记为一个错误。 -使用算法:产生简单的命令行程序,然后海伦可以输入一些特征数据以判断对方是否为自己喜欢的类型。 +使用算法: 产生简单的命令行程序,然后海伦可以输入一些特征数据以判断对方是否为自己喜欢的类型。 ``` -> 收集数据:提供文本文件 +> 收集数据: 提供文本文件 -海伦把这些约会对象的数据存放在文本文件 [datingTestSet2.txt](/data/2.KNN/datingTestSet2.txt) 中,总共有 1000 行。海伦约会的对象主要包含以下 3 种特征: +海伦把这些约会对象的数据存放在文本文件 [datingTestSet2.txt](/data/2.KNN/datingTestSet2.txt) 中,总共有 1000 行。海伦约会的对象主要包含以下 3 种特征: * 每年获得的飞行常客里程数 * 玩视频游戏所耗时间百分比 * 每周消费的冰淇淋公升数 -文本文件数据格式如下: +文本文件数据格式如下: ``` 40920 8.326976 0.953952 3 14488 7.153469 1.673904 2 @@ -112,7 +112,7 @@ knn 算法按照距离最近的三部电影的类型,决定未知电影的类 75136 13.147394 0.428964 1 38344 1.669788 0.134296 1 ``` -> 准备数据:使用 Python 解析文本文件 +> 准备数据: 使用 Python 解析文本文件 将文本记录转换为 NumPy 的解析程序 @@ -130,7 +130,7 @@ def file2matrix(filename): # 获得文件中的数据行的行数 numberOfLines = len(fr.readlines()) # 生成对应的空矩阵 - # 例如:zeros(2,3)就是生成一个 2*3的矩阵,各个位置上全是 0 + # 例如: zeros(2,3)就是生成一个 2*3的矩阵,各个位置上全是 0 returnMat = zeros((numberOfLines, 3)) # prepare matrix to return classLabelVector = [] # prepare labels return fr = open(filename) @@ -149,7 +149,7 @@ def file2matrix(filename): return returnMat, classLabelVector ``` -> 分析数据:使用 Matplotlib 画二维散点图 +> 分析数据: 使用 Matplotlib 画二维散点图 ```python import matplotlib @@ -164,7 +164,7 @@ plt.show()  -* 归一化数据 (归一化是一个让权重变为统一的过程,更多细节请参考: https://www.zhihu.com/question/19951858 ) +* 归一化数据 (归一化是一个让权重变为统一的过程,更多细节请参考: https://www.zhihu.com/question/19951858 ) | 序号 | 玩视频游戏所耗时间百分比 | 每年获得的飞行常客里程数 | 每周消费的冰淇淋公升数 | 样本分类 | | ------------- |:-------------:| -----:| -----:| -----:| @@ -173,34 +173,34 @@ plt.show() | 3 | 0 | 20 000 | 1.1 | 2 | | 4 | 67 | 32 000 | 0.1 | 2 | -样本3和样本4的距离: +样本3和样本4的距离: $$\sqrt{(0-67)^2 + (20000-32000)^2 + (1.1-0.1)^2 }$$ 归一化特征值,消除特征之间量级不同导致的影响 -**归一化定义:** 我是这样认为的,归一化就是要把你需要处理的数据经过处理后(通过某种算法)限制在你需要的一定范围内。首先归一化是为了后面数据处理的方便,其次是保正程序运行时收敛加快。 方法有如下: +**归一化定义: ** 我是这样认为的,归一化就是要把你需要处理的数据经过处理后(通过某种算法)限制在你需要的一定范围内。首先归一化是为了后面数据处理的方便,其次是保正程序运行时收敛加快。 方法有如下: -1) 线性函数转换,表达式如下: +1) 线性函数转换,表达式如下: y=(x-MinValue)/(MaxValue-MinValue) - 说明:x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。 + 说明: x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最大值和最小值。 -2) 对数函数转换,表达式如下: +2) 对数函数转换,表达式如下: y=log10(x) - 说明:以10为底的对数函数转换。 + 说明: 以10为底的对数函数转换。 - 如图: + 如图:  -3) 反余切函数转换,表达式如下: +3) 反余切函数转换,表达式如下: y=arctan(x)*2/PI - 如图: + 如图:  @@ -220,7 +220,7 @@ def autoNorm(dataSet): return: 归一化后的数据集 normDataSet. ranges和minVals即最小值与范围,并没有用到 - 归一化公式: + 归一化公式: Y = (X-Xmin)/(Xmax-Xmin) 其中的 min 和 max 分别是数据集中的最小特征值和最大特征值。该函数可以自动将数字特征值转化为0到1的区间。 """ @@ -238,15 +238,15 @@ def autoNorm(dataSet): return normDataSet, ranges, minVals ``` -> 训练算法:此步骤不适用于 k-近邻算法 +> 训练算法: 此步骤不适用于 k-近邻算法 因为测试数据每一次都要与全量的训练数据进行比较,所以这个过程是没有必要的。 -kNN 算法伪代码: +kNN 算法伪代码: - 对于每一个在数据集中的数据点: + 对于每一个在数据集中的数据点: 计算目标的数据点(需要分类的数据点)与该数据点的距离 - 将距离排序:从小到大 + 将距离排序: 从小到大 选取前K个最短距离 选取这K个中最多的分类类别 返回该类别来作为目标数据点的预测值 @@ -259,11 +259,11 @@ def classify0(inX, dataSet, labels, k): sqDistances = sqDiffMat.sum(axis=1) distances = sqDistances**0.5 - #将距离排序:从小到大 + #将距离排序: 从小到大 sortedDistIndicies = distances.argsort() #选取前K个最短距离, 选取这K个中最多的分类类别 classCount={} - for i in range(k): + for i in range(k): voteIlabel = labels[sortedDistIndicies[i]] classCount[voteIlabel] = classCount.get(voteIlabel,0) + 1 sortedClassCount = sorted(classCount.iteritems(), key=operator.itemgetter(1), reverse=True) @@ -271,7 +271,7 @@ def classify0(inX, dataSet, labels, k): ``` -> 测试算法:使用海伦提供的部分数据作为测试样本。如果预测分类与实际类别不同,则标记为一个错误。 +> 测试算法: 使用海伦提供的部分数据作为测试样本。如果预测分类与实际类别不同,则标记为一个错误。 kNN 分类器针对约会网站的测试代码 @@ -306,7 +306,7 @@ def datingClassTest(): print errorCount ``` -> 使用算法:产生简单的命令行程序,然后海伦可以输入一些特征数据以判断对方是否为自己喜欢的类型。 +> 使用算法: 产生简单的命令行程序,然后海伦可以输入一些特征数据以判断对方是否为自己喜欢的类型。 约会网站预测函数 @@ -343,19 +343,19 @@ You will probably like this person: in small doses 构造一个能识别数字 0 到 9 的基于 KNN 分类器的手写数字识别系统。 -需要识别的数字是存储在文本文件中的具有相同的色彩和大小:宽高是 32 像素 * 32 像素的黑白图像。 +需要识别的数字是存储在文本文件中的具有相同的色彩和大小: 宽高是 32 像素 * 32 像素的黑白图像。 #### 开发流程 ``` -收集数据:提供文本文件。 -准备数据:编写函数 img2vector(), 将图像格式转换为分类器使用的向量格式 -分析数据:在 Python 命令提示符中检查数据,确保它符合要求 -训练算法:此步骤不适用于 KNN -测试算法:编写函数使用提供的部分数据集作为测试样本,测试样本与非测试样本的 +收集数据: 提供文本文件。 +准备数据: 编写函数 img2vector(), 将图像格式转换为分类器使用的向量格式 +分析数据: 在 Python 命令提示符中检查数据,确保它符合要求 +训练算法: 此步骤不适用于 KNN +测试算法: 编写函数使用提供的部分数据集作为测试样本,测试样本与非测试样本的 区别在于测试样本是已经完成分类的数据,如果预测分类与实际类别不同, 则标记为一个错误 -使用算法:本例没有完成此步骤,若你感兴趣可以构建完整的应用程序,从图像中提取 +使用算法: 本例没有完成此步骤,若你感兴趣可以构建完整的应用程序,从图像中提取 数字,并完成数字识别,美国的邮件分拣系统就是一个实际运行的类似系统 ``` @@ -380,7 +380,7 @@ def img2vector(filename): return returnVect ``` -> 分析数据:在 Python 命令提示符中检查数据,确保它符合要求 +> 分析数据: 在 Python 命令提示符中检查数据,确保它符合要求 在 Python 命令行中输入下列命令测试 img2vector 函数,然后与文本编辑器打开的文件进行比较: @@ -392,11 +392,11 @@ array([0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 1., 1., 1., 0 array([0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 1., 1., 1., 1., 1., 1., 1., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0., 0.]) ``` -> 训练算法:此步骤不适用于 KNN +> 训练算法: 此步骤不适用于 KNN 因为测试数据每一次都要与全量的训练数据进行比较,所以这个过程是没有必要的。 -> 测试算法:编写函数使用提供的部分数据集作为测试样本,如果预测分类与实际类别不同,则标记为一个错误 +> 测试算法: 编写函数使用提供的部分数据集作为测试样本,如果预测分类与实际类别不同,则标记为一个错误 ```python def handwritingClassTest(): @@ -430,17 +430,17 @@ def handwritingClassTest(): print "\nthe total error rate is: %f" % (errorCount / float(mTest)) ``` -> 使用算法:本例没有完成此步骤,若你感兴趣可以构建完整的应用程序,从图像中提取数字,并完成数字识别,美国的邮件分拣系统就是一个实际运行的类似系统。 +> 使用算法: 本例没有完成此步骤,若你感兴趣可以构建完整的应用程序,从图像中提取数字,并完成数字识别,美国的邮件分拣系统就是一个实际运行的类似系统。 ## KNN 小结 -KNN 是什么?定义: 监督学习? 非监督学习? +KNN 是什么?定义: 监督学习? 非监督学习? KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模型。在分类和回归中均有应用。 ### 基本原理 -简单来说: 通过距离度量来计算查询点(query point)与每个训练数据点的距离,然后选出与查询点(query point)相近的K个最邻点(K nearest neighbors),使用分类决策来选出对应的标签来作为该查询点的标签。 +简单来说: 通过距离度量来计算查询点(query point)与每个训练数据点的距离,然后选出与查询点(query point)相近的K个最邻点(K nearest neighbors),使用分类决策来选出对应的标签来作为该查询点的标签。 ### KNN 三要素 @@ -454,7 +454,7 @@ KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模 >>>>太大太小都不太好,可以用交叉验证(cross validation)来选取适合的k值。 ->>>>近似误差和估计误差,请看这里:https://www.zhihu.com/question/60793482 +>>>>近似误差和估计误差,请看这里: https://www.zhihu.com/question/60793482 >距离度量 Metric/Distance Measure @@ -464,7 +464,7 @@ KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模 >>>>分类决策 在 分类问题中 通常为通过少数服从多数 来选取票数最多的标签,在回归问题中通常为 K个最邻点的标签的平均值。 -### 算法:(sklearn 上有三种) +### 算法: (sklearn 上有三种) >Brute Force 暴力计算/线性扫描 @@ -474,27 +474,27 @@ KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模 >树结构的算法都有建树和查询两个过程。Brute Force 没有建树的过程。 ->算法特点: +>算法特点: ->>>>优点: High Accuracy, No Assumption on data, not sensitive to outliers +>>>>优点: High Accuracy, No Assumption on data, not sensitive to outliers ->>>>缺点:时间和空间复杂度 高 +>>>>缺点: 时间和空间复杂度 高 ->>>>适用范围: continuous values and nominal values +>>>>适用范围: continuous values and nominal values ->相似同源产物: +>相似同源产物: >>>>radius neighbors 根据制定的半径来找寻邻点 ->影响算法因素: +>影响算法因素: >>>>N 数据集样本数量(number of samples), D 数据维度 (number of features) ->总消耗: +>总消耗: >>>>Brute Force: O[DN^2] ->>>>此处考虑的是最蠢的方法:把所有训练的点之间的距离都算一遍。当然有更快的实现方式, 比如 O(ND + kN) 和 O(NDK) , 最快的是 O[DN] 。感兴趣的可以阅读这个链接: [k-NN computational complexity](https://stats.stackexchange.com/questions/219655/k-nn-computational-complexity) +>>>>此处考虑的是最蠢的方法: 把所有训练的点之间的距离都算一遍。当然有更快的实现方式, 比如 O(ND + kN) 和 O(NDK) , 最快的是 O[DN] 。感兴趣的可以阅读这个链接: [k-NN computational complexity](https://stats.stackexchange.com/questions/219655/k-nn-computational-complexity) >>>>KD Tree: O[DN log(N)] @@ -530,7 +530,7 @@ KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模 >>>>查询点较少的时候用Brute Force。查询点较多的时候可以使用树结构算法。 ->关于 sklearn 中模型的一些额外干货: +>关于 sklearn 中模型的一些额外干货: >>>>如果KD Tree,Ball Tree 和Brute Force 应用场景傻傻分不清楚,可以直接使用 含有algorithm='auto'的模组。 algorithm='auto' 自动为您选择最优算法。 >>>>有 regressor 和 classifier 可以来选择。 @@ -539,11 +539,11 @@ KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模 >leaf size 对KD Tree 和 Ball Tree 的影响 ->>>>建树时间:leaf size 比较大的时候,建树时间也就快点。 +>>>>建树时间: leaf size 比较大的时候,建树时间也就快点。 ->>>>查询时间: leaf size 太大太小都不太好。如果leaf size 趋向于 N(训练数据的样本数量),算法其实就是 brute force了。如果leaf size 太小了,趋向于1,那查询的时候 遍历树的时间就会大大增加。leaf size 建议的数值是 30,也就是默认值。 +>>>>查询时间: leaf size 太大太小都不太好。如果leaf size 趋向于 N(训练数据的样本数量),算法其实就是 brute force了。如果leaf size 太小了,趋向于1,那查询的时候 遍历树的时间就会大大增加。leaf size 建议的数值是 30,也就是默认值。 ->>>>内存: leaf size 变大,存树结构的内存变小。 +>>>>内存: leaf size 变大,存树结构的内存变小。 >Nearest Centroid Classifier @@ -551,17 +551,17 @@ KNN 是一个简单的无显示学习过程,非泛化学习的监督学习模 >>>>该模型假设在所有维度中方差相同。 是一个很好的base line。 ->进阶版: Nearest Shrunken Centroid +>进阶版: Nearest Shrunken Centroid >>>>可以通过shrink_threshold来设置。 ->>>>作用: 可以移除某些影响分类的特征,例如移除噪音特征的影响 +>>>>作用: 可以移除某些影响分类的特征,例如移除噪音特征的影响 * * * -* **作者:[羊三](http://cwiki.apachecn.org/display/~xuxin) [小瑶](http://cwiki.apachecn.org/display/~chenyao)** +* **作者: [羊三](http://cwiki.apachecn.org/display/~xuxin) [小瑶](http://cwiki.apachecn.org/display/~chenyao)** * [GitHub地址](https://github.com/apachecn/AiLearning):

-我们使用 createBranch() 方法,如下所示: +我们使用 createBranch() 方法,如下所示: ``` def createBranch(): @@ -71,20 +71,20 @@ def createBranch(): ### 决策树 开发流程 ``` -收集数据:可以使用任何方法。 -准备数据:树构造算法 (这里使用的是ID3算法,只适用于标称型数据,这就是为什么数值型数据必须离散化。 还有其他的树构造算法,比如CART) -分析数据:可以使用任何方法,构造树完成之后,我们应该检查图形是否符合预期。 -训练算法:构造树的数据结构。 -测试算法:使用训练好的树计算错误率。 -使用算法:此步骤可以适用于任何监督学习任务,而使用决策树可以更好地理解数据的内在含义。 +收集数据: 可以使用任何方法。 +准备数据: 树构造算法 (这里使用的是ID3算法,只适用于标称型数据,这就是为什么数值型数据必须离散化。 还有其他的树构造算法,比如CART) +分析数据: 可以使用任何方法,构造树完成之后,我们应该检查图形是否符合预期。 +训练算法: 构造树的数据结构。 +测试算法: 使用训练好的树计算错误率。 +使用算法: 此步骤可以适用于任何监督学习任务,而使用决策树可以更好地理解数据的内在含义。 ``` ### 决策树 算法特点 ``` -优点:计算复杂度不高,输出结果易于理解,数据有缺失也能跑,可以处理不相关特征。 -缺点:容易过拟合。 -适用数据类型:数值型和标称型。 +优点: 计算复杂度不高,输出结果易于理解,数据有缺失也能跑,可以处理不相关特征。 +缺点: 容易过拟合。 +适用数据类型: 数值型和标称型。 ``` ## 决策树 项目案例 @@ -93,9 +93,9 @@ def createBranch(): #### 项目概述 -根据以下 2 个特征,将动物分成两类:鱼类和非鱼类。 +根据以下 2 个特征,将动物分成两类: 鱼类和非鱼类。 -特征: +特征: 1. 不浮出水面是否可以生存 2. 是否有脚蹼 @@ -104,15 +104,15 @@ def createBranch(): [完整代码地址](/src/py2.x/ml/3.DecisionTree/DecisionTree.py):

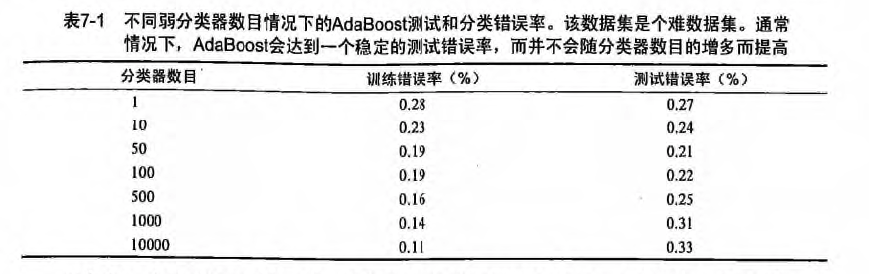

-选男友:美女选择择偶对象的时候,会问几个闺蜜的建议,最后选择一个综合得分最高的一个作为男朋友 +选男友: 美女选择择偶对象的时候,会问几个闺蜜的建议,最后选择一个综合得分最高的一个作为男朋友 目前 boosting 方法最流行的版本是: AdaBoost

-追女友:3个帅哥追同一个美女,第1个帅哥失败->(传授经验:姓名、家庭情况) 第2个帅哥失败->(传授经验:兴趣爱好、性格特点) 第3个帅哥成功 +追女友: 3个帅哥追同一个美女,第1个帅哥失败->(传授经验: 姓名、家庭情况) 第2个帅哥失败->(传授经验: 兴趣爱好、性格特点) 第3个帅哥成功 > bagging 和 boosting 区别是什么? @@ -38,15 +38,15 @@ ### 随机森林 原理 那随机森林具体如何构建呢?

-有两个方面:

+有两个方面:

1. 数据的随机性化

2. 待选特征的随机化

使得随机森林中的决策树都能够彼此不同,提升系统的多样性,从而提升分类性能。 -> 数据的随机化:使得随机森林中的决策树更普遍化一点,适合更多的场景。 +> 数据的随机化: 使得随机森林中的决策树更普遍化一点,适合更多的场景。 -(有放回的准确率在:70% 以上, 无放回的准确率在:60% 以上) +(有放回的准确率在: 70% 以上, 无放回的准确率在: 60% 以上) 1. 采取有放回的抽样方式 构造子数据集,保证不同子集之间的数量级一样(不同子集/同一子集 之间的元素可以重复) 2. 利用子数据集来构建子决策树,将这个数据放到每个子决策树中,每个子决策树输出一个结果。 3. 然后统计子决策树的投票结果,得到最终的分类 就是 随机森林的输出结果。 @@ -68,20 +68,20 @@ > 随机森林 开发流程 ``` -收集数据:任何方法 -准备数据:转换样本集 -分析数据:任何方法 -训练算法:通过数据随机化和特征随机化,进行多实例的分类评估 -测试算法:计算错误率 -使用算法:输入样本数据,然后运行 随机森林 算法判断输入数据分类属于哪个分类,最后对计算出的分类执行后续处理 +收集数据: 任何方法 +准备数据: 转换样本集 +分析数据: 任何方法 +训练算法: 通过数据随机化和特征随机化,进行多实例的分类评估 +测试算法: 计算错误率 +使用算法: 输入样本数据,然后运行 随机森林 算法判断输入数据分类属于哪个分类,最后对计算出的分类执行后续处理 ``` > 随机森林 算法特点 ``` -优点:几乎不需要输入准备、可实现隐式特征选择、训练速度非常快、其他模型很难超越、很难建立一个糟糕的随机森林模型、大量优秀、免费以及开源的实现。 -缺点:劣势在于模型大小、是个很难去解释的黑盒子。 -适用数据范围:数值型和标称型 +优点: 几乎不需要输入准备、可实现隐式特征选择、训练速度非常快、其他模型很难超越、很难建立一个糟糕的随机森林模型、大量优秀、免费以及开源的实现。 +缺点: 劣势在于模型大小、是个很难去解释的黑盒子。 +适用数据范围: 数值型和标称型 ``` ### 项目案例: 声纳信号分类 @@ -93,17 +93,17 @@ #### 开发流程 ``` -收集数据:提供的文本文件 -准备数据:转换样本集 -分析数据:手工检查数据 -训练算法:在数据上,利用 random_forest() 函数进行优化评估,返回模型的综合分类结果 -测试算法:在采用自定义 n_folds 份随机重抽样 进行测试评估,得出综合的预测评分 -使用算法:若你感兴趣可以构建完整的应用程序,从案例进行封装,也可以参考我们的代码 +收集数据: 提供的文本文件 +准备数据: 转换样本集 +分析数据: 手工检查数据 +训练算法: 在数据上,利用 random_forest() 函数进行优化评估,返回模型的综合分类结果 +测试算法: 在采用自定义 n_folds 份随机重抽样 进行测试评估,得出综合的预测评分 +使用算法: 若你感兴趣可以构建完整的应用程序,从案例进行封装,也可以参考我们的代码 ``` -> 收集数据:提供的文本文件 +> 收集数据: 提供的文本文件 -样本数据:sonar-all-data.txt +样本数据: sonar-all-data.txt ``` 0.02,0.0371,0.0428,0.0207,0.0954,0.0986,0.1539,0.1601,0.3109,0.2111,0.1609,0.1582,0.2238,0.0645,0.066,0.2273,0.31,0.2999,0.5078,0.4797,0.5783,0.5071,0.4328,0.555,0.6711,0.6415,0.7104,0.808,0.6791,0.3857,0.1307,0.2604,0.5121,0.7547,0.8537,0.8507,0.6692,0.6097,0.4943,0.2744,0.051,0.2834,0.2825,0.4256,0.2641,0.1386,0.1051,0.1343,0.0383,0.0324,0.0232,0.0027,0.0065,0.0159,0.0072,0.0167,0.018,0.0084,0.009,0.0032,R @@ -111,7 +111,7 @@ 0.0262,0.0582,0.1099,0.1083,0.0974,0.228,0.2431,0.3771,0.5598,0.6194,0.6333,0.706,0.5544,0.532,0.6479,0.6931,0.6759,0.7551,0.8929,0.8619,0.7974,0.6737,0.4293,0.3648,0.5331,0.2413,0.507,0.8533,0.6036,0.8514,0.8512,0.5045,0.1862,0.2709,0.4232,0.3043,0.6116,0.6756,0.5375,0.4719,0.4647,0.2587,0.2129,0.2222,0.2111,0.0176,0.1348,0.0744,0.013,0.0106,0.0033,0.0232,0.0166,0.0095,0.018,0.0244,0.0316,0.0164,0.0095,0.0078,R ``` -> 准备数据:转换样本集 +> 准备数据: 转换样本集 ```python # 导入csv文件 @@ -135,9 +135,9 @@ def loadDataSet(filename): return dataset ``` -> 分析数据:手工检查数据 +> 分析数据: 手工检查数据 -> 训练算法:在数据上,利用 random_forest() 函数进行优化评估,返回模型的综合分类结果 +> 训练算法: 在数据上,利用 random_forest() 函数进行优化评估,返回模型的综合分类结果 * 样本数据随机无放回抽样-用于交叉验证 @@ -149,7 +149,7 @@ def cross_validation_split(dataset, n_folds): dataset 原始数据集 n_folds 数据集dataset分成n_flods份 Returns: - dataset_split list集合,存放的是:将数据集进行抽重抽样 n_folds 份,数据可以重复抽取 + dataset_split list集合,存放的是: 将数据集进行抽重抽样 n_folds 份,数据可以重复抽取 """ dataset_split = list() dataset_copy = list(dataset) # 复制一份 dataset,防止 dataset 的内容改变 @@ -249,7 +249,7 @@ def random_forest(train, test, max_depth, min_size, sample_size, n_trees, n_feat return predictions ``` -> 测试算法:在采用自定义 n_folds 份随机重抽样 进行测试评估,得出综合的预测评分。 +> 测试算法: 在采用自定义 n_folds 份随机重抽样 进行测试评估,得出综合的预测评分。 * 计算随机森林的预测结果的正确率 @@ -302,7 +302,7 @@ def evaluate_algorithm(dataset, algorithm, n_folds, *args): return scores ``` -> 使用算法:若你感兴趣可以构建完整的应用程序,从案例进行封装,也可以参考我们的代码 +> 使用算法: 若你感兴趣可以构建完整的应用程序,从案例进行封装,也可以参考我们的代码 [完整代码地址](https://github.com/apachecn/AiLearning/blob/master/src/py2.x/ml/7.RandomForest/randomForest.py):

-测试数据:horseColicTest.txt +训练数据: horseColicTraining.txt

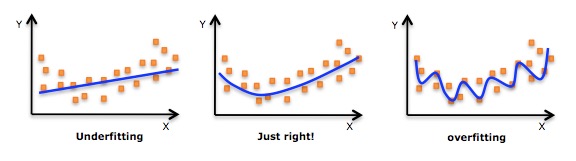

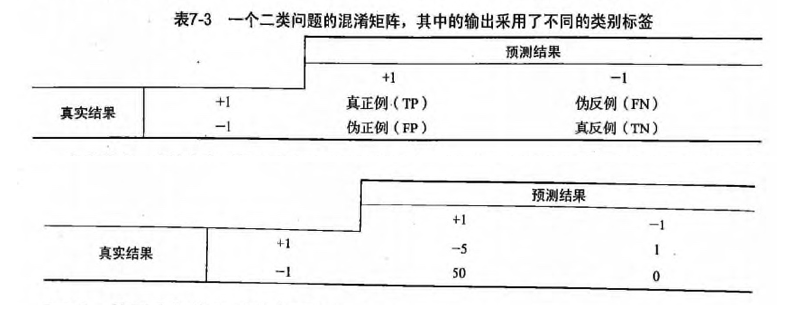

+测试数据: horseColicTest.txt ``` 2.000000 1.000000 38.500000 66.000000 28.000000 3.000000 3.000000 0.000000 2.000000 5.000000 4.000000 4.000000 0.000000 0.000000 0.000000 3.000000 5.000000 45.000000 8.400000 0.000000 0.000000 -1.000000 @@ -375,7 +375,7 @@ def evaluate_algorithm(dataset, algorithm, n_folds, *args): 2.000000 1.000000 38.300000 40.000000 24.000000 1.000000 1.000000 3.000000 1.000000 3.000000 3.000000 1.000000 0.000000 0.000000 0.000000 1.000000 1.000000 33.000000 6.700000 0.000000 0.000000 1.000000 ``` -> 准备数据:确保类别标签是+1和-1,而非1和0 +> 准备数据: 确保类别标签是+1和-1,而非1和0 ```python def loadDataSet(fileName): @@ -394,18 +394,18 @@ def loadDataSet(fileName): return dataArr, labelArr ``` -> 分析数据:统计分析 +> 分析数据: 统计分析 过拟合(overfitting, 也称为过学习) * 发现测试错误率在达到一个最小值之后有开始上升,这种现象称为过拟合。  -* 通俗来说:就是把一些噪音数据也拟合进去的,如下图。 +* 通俗来说: 就是把一些噪音数据也拟合进去的,如下图。  -> 训练算法:在数据上,利用 adaBoostTrainDS() 函数训练出一系列的分类器 +> 训练算法: 在数据上,利用 adaBoostTrainDS() 函数训练出一系列的分类器 ```python def adaBoostTrainDS(dataArr, labelArr, numIt=40): @@ -435,21 +435,21 @@ def adaBoostTrainDS(dataArr, labelArr, numIt=40): weakClassArr.append(bestStump) print "alpha=%s, classEst=%s, bestStump=%s, error=%s " % (alpha, classEst.T, bestStump, error) - # 分类正确:乘积为1,不会影响结果,-1主要是下面求e的-alpha次方 - # 分类错误:乘积为 -1,结果会受影响,所以也乘以 -1 + # 分类正确: 乘积为1,不会影响结果,-1主要是下面求e的-alpha次方 + # 分类错误: 乘积为 -1,结果会受影响,所以也乘以 -1 expon = multiply(-1*alpha*mat(labelArr).T, classEst) print '(-1取反)预测值expon=', expon.T # 计算e的expon次方,然后计算得到一个综合的概率的值 - # 结果发现: 判断错误的样本,D中相对应的样本权重值会变大。 + # 结果发现: 判断错误的样本,D中相对应的样本权重值会变大。 D = multiply(D, exp(expon)) D = D/D.sum() # 预测的分类结果值,在上一轮结果的基础上,进行加和操作 - print '当前的分类结果:', alpha*classEst.T + print '当前的分类结果: ', alpha*classEst.T aggClassEst += alpha*classEst print "叠加后的分类结果aggClassEst: ", aggClassEst.T # sign 判断正为1, 0为0, 负为-1,通过最终加和的权重值,判断符号。 - # 结果为:错误的样本标签集合,因为是 !=,那么结果就是0 正, 1 负 + # 结果为: 错误的样本标签集合,因为是 !=,那么结果就是0 正, 1 负 aggErrors = multiply(sign(aggClassEst) != mat(labelArr).T, ones((m, 1))) errorRate = aggErrors.sum()/m # print "total error=%s " % (errorRate) @@ -459,16 +459,16 @@ def adaBoostTrainDS(dataArr, labelArr, numIt=40): ``` ``` -发现: +发现: alpha (模型权重)目的主要是计算每一个分类器实例的权重(加和就是分类结果) - 分类的权重值:最大的值= alpha 的加和,最小值=-最大值 -D (样本权重)的目的是为了计算错误概率: weightedError = D.T*errArr,求最佳分类器 - 样本的权重值:如果一个值误判的几率越小,那么 D 的样本权重越小 + 分类的权重值: 最大的值= alpha 的加和,最小值=-最大值 +D (样本权重)的目的是为了计算错误概率: weightedError = D.T*errArr,求最佳分类器 + 样本的权重值: 如果一个值误判的几率越小,那么 D 的样本权重越小 ```  -> 测试算法:我们拥有两个数据集。在不采用随机抽样的方法下,我们就会对 AdaBoost 和 Logistic 回归的结果进行完全对等的比较。 +> 测试算法: 我们拥有两个数据集。在不采用随机抽样的方法下,我们就会对 AdaBoost 和 Logistic 回归的结果进行完全对等的比较。 ```python def adaClassify(datToClass, classifierArr): @@ -486,14 +486,14 @@ def adaClassify(datToClass, classifierArr): # 循环 多个分类器 for i in range(len(classifierArr)): - # 前提: 我们已经知道了最佳的分类器的实例 + # 前提: 我们已经知道了最佳的分类器的实例 # 通过分类器来核算每一次的分类结果,然后通过alpha*每一次的结果 得到最后的权重加和的值。 classEst = stumpClassify(dataMat, classifierArr[i]['dim'], classifierArr[i]['thresh'], classifierArr[i]['ineq']) aggClassEst += classifierArr[i]['alpha']*classEst return sign(aggClassEst) ``` -> 使用算法:观察该例子上的错误率。不过,也可以构建一个 Web 网站,让驯马师输入马的症状然后预测马是否会死去。 +> 使用算法: 观察该例子上的错误率。不过,也可以构建一个 Web 网站,让驯马师输入马的症状然后预测马是否会死去。 ```python # 马疝病数据集 @@ -508,7 +508,7 @@ dataArrTest, labelArrTest = loadDataSet("data/7.AdaBoost/horseColicTest2.txt") m = shape(dataArrTest)[0] predicting10 = adaClassify(dataArrTest, weakClassArr) errArr = mat(ones((m, 1))) -# 测试:计算总样本数,错误样本数,错误率 +# 测试: 计算总样本数,错误样本数,错误率 print m, errArr[predicting10 != mat(labelArrTest).T].sum(), errArr[predicting10 != mat(labelArrTest).T].sum()/m ``` @@ -516,7 +516,7 @@ print m, errArr[predicting10 != mat(labelArrTest).T].sum(), errArr[predicting10 #### 要点补充 -> 非均衡现象: +> 非均衡现象: `在分类器训练时,正例数目和反例数目不相等(相差很大)。或者发生在正负例分类错误的成本不同的时候。` @@ -525,9 +525,9 @@ print m, errArr[predicting10 != mat(labelArrTest).T].sum(), errArr[predicting10 * 不能放过传染病的人 * 不能随便认为别人犯罪 -我们有多种方法来处理这个问题: 具体可参考[此链接](https://machinelearningmastery.com/tactics-to-combat-imbalanced-classes-in-your-machine-learning-dataset/) +我们有多种方法来处理这个问题: 具体可参考[此链接](https://machinelearningmastery.com/tactics-to-combat-imbalanced-classes-in-your-machine-learning-dataset/) -再结合书中的方法,可以归为八大类: +再结合书中的方法,可以归为八大类: ##### 1.能否收集到更多的数据? @@ -538,13 +538,13 @@ print m, errArr[predicting10 != mat(labelArrTest).T].sum(), errArr[predicting10 Accuracy 或者error rate 不能用于非均衡的数据集。这会误导人。这时候可以尝试其他的评价指标。 -Confusion Matrix 混淆矩阵:使用一个表格对分类器所预测的类别与其真实的类别的样本统计,分别为:TP、FN、FP与TN。 +Confusion Matrix 混淆矩阵: 使用一个表格对分类器所预测的类别与其真实的类别的样本统计,分别为: TP、FN、FP与TN。 -Precision:精确度 +Precision: 精确度 -Recall: 召回率 +Recall: 召回率 -F1 Score (or F-Score): 精确度和召回率的加权平均 +F1 Score (or F-Score): 精确度和召回率的加权平均 或者使用 @@ -577,7 +577,7 @@ ROC Curves 或者结合上述两种方法进行抽样 -一些经验法则: +一些经验法则: * 考虑样本(超过1万、十万甚至更多)进行欠采样,即删除部分样本; @@ -609,11 +609,11 @@ python实现可以查阅[UnbalancedDataset](https://github.com/scikit-learn-cont 惩罚的模型就是对于不同的分类错误给予不同的代价(惩罚)。比如对于错分的小类给予更高的代价。这种方式会使模型偏差,更加关注小类。 -通常来说这种代价/惩罚或者比重在学习中算法是特定的。比如使用代价函数来实现: +通常来说这种代价/惩罚或者比重在学习中算法是特定的。比如使用代价函数来实现: > 代价函数 -* 基于代价函数的分类器决策控制:`TP*(-5)+FN*1+FP*50+TN*0` +* 基于代价函数的分类器决策控制: `TP*(-5)+FN*1+FP*50+TN*0`  @@ -627,7 +627,7 @@ python实现可以查阅[UnbalancedDataset](https://github.com/scikit-learn-cont 从它们的角度看看你的问题,思考你的问题,说不定会有新的想法。 -两个领域您可以考虑: anomaly detection(异常值检测) 和 change detection(变化趋势检测)。 +两个领域您可以考虑: anomaly detection(异常值检测) 和 change detection(变化趋势检测)。 Anomaly dectection 就是检测稀有事件。 比如通过机器震动来识别机器谷中或者根据一系列系统的调用来检测恶意操作。与常规操作相比,这些事件是罕见的。 @@ -641,7 +641,7 @@ change detection 变化趋势检测类似于异常值检测。但是他不是寻 仔细思考你的问题然后想想看如何将这问题细分为几个更切实际的小问题。 -比如: +比如: 将你的大类分解成多个较小的类; @@ -655,6 +655,6 @@ change detection 变化趋势检测类似于异常值检测。但是他不是寻 * * * -* **作者:[片刻](https://github.com/jiangzhonglian)** +* **作者: [片刻](https://github.com/jiangzhonglian)** * [GitHub地址](https://github.com/apachecn/AiLearning):

'+ + '\\n'+ + '\\n

'+

+ '\\n '+

+ '\\n '+

+ '\\n '+

+ '\\n '+

+ '\\n'+

+ '\\n '+

+ '\\n'+

+ '\\n '+

+ '\\n '+

+ '\\n

'+

+ '\\n'+

+ '\\n'+

+ '\\n'+

+ '\\n'+

+ '\\n '+

+ '\\n '+

+ '\\n '+

+ '\\n '+

+ '\\n '+

+ '\\n

'

+

+ str += '\\n\\n'

+ """

+

+ # 状态为 True 就进行替换

+ if tag: format_file(filename, str1, str2)

diff --git a/tool/DecisionTree_getInfoGain.py b/tool/DecisionTree_getInfoGain.py

index 3e775203e..c96f6ebeb 100644

--- a/tool/DecisionTree_getInfoGain.py

+++ b/tool/DecisionTree_getInfoGain.py

@@ -57,7 +57,7 @@ def splitDataSet(dataSet, axis, value):

# chop out axis used for splitting

reducedFeatVec = featVec[:axis]

'''

- 请百度查询一下: extend和append的区别

+ 请百度查询一下: extend和append的区别

'''

reducedFeatVec.extend(featVec[axis+1:])

# 收集结果值 axis列为value的行【该行需要排除axis列】

diff --git a/update.sh b/update.sh

new file mode 100644

index 000000000..f76166c4e

--- /dev/null

+++ b/update.sh

@@ -0,0 +1,3 @@

+git add -A

+git commit -am "$(date "+%Y-%m-%d %H:%M:%S")"

+git push

\ No newline at end of file

![ApacheCN - 学习机器学习群[724187166] ApacheCN - 学习机器学习群[724187166]](http://data.apachecn.org/img/logo/ApacheCN-group.png) **

-> **欢迎任何人参与和完善:一个人可以走的很快,但是一群人却可以走的更远**

+> **欢迎任何人参与和完善: 一个人可以走的很快,但是一群人却可以走的更远**

# 路线图

@@ -33,7 +33,7 @@

* 机器学习下载地址:

**

-> **欢迎任何人参与和完善:一个人可以走的很快,但是一群人却可以走的更远**

+> **欢迎任何人参与和完善: 一个人可以走的很快,但是一群人却可以走的更远**

# 路线图

@@ -33,7 +33,7 @@

* 机器学习下载地址: